Se chegou aqui e ainda não leu os outros artigos, então pare e leia agora:

Eu já fiz minha reclamação de velho rabugento sobre o inverno. Agora é hora e a época do ano pra falar um pouco sobre o verão.

O verão na Suécia é lindo e maravilhoso. Só que é curto. O tempo começa a esquentar mesmo em junho. Antes disso temos alguns dias mais quentes, mas em geral as noites são bem geladas.

Mas o que começa a pegar bastante em junho não é a temperatura mais quente, mas o sol. Muito de sol.

Essa foto eu tirei à 01:10 da manhã. Estava vendo filme e fui dormir mais tarde. Durante boa parte de junho e julho não tem noite. Fica nesse entardecer e o sol volta. O solstício de verão, dia mais longo do ano, ocorre em 21 de junho.

É maravilhoso. Você fica num bar, aquela cara de fim de tarde e quando vai olhar já são 2 horas da manhã.

O ruim é pra dormir. Ou mesmo ver filmes. Você tem de ter as janelas bloqueadas com blackout ou alguma outra curtina pesada dessas.

E a criançada brinca nos parques até 22:00 como se não houvesse amanhã.

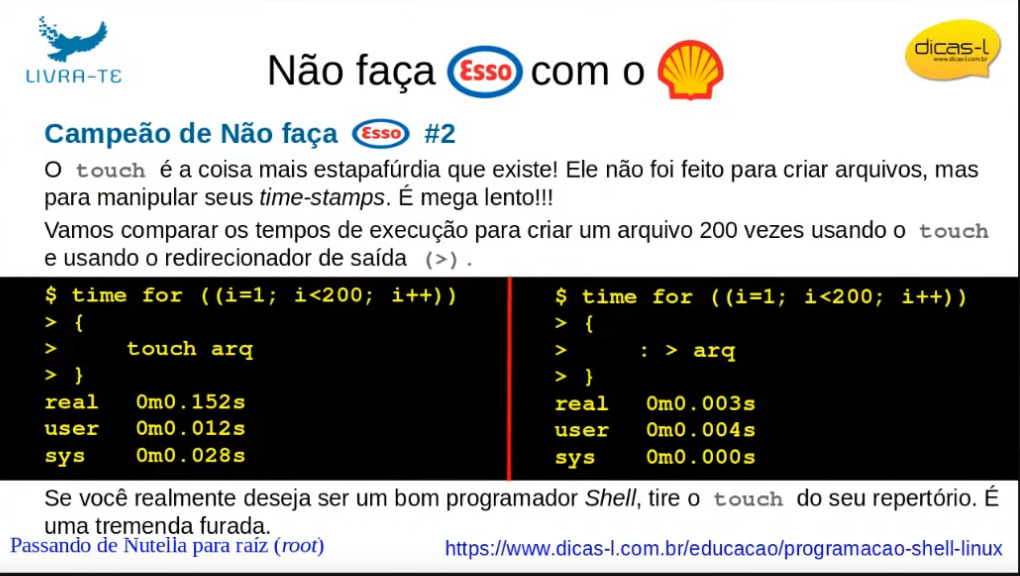

Durante a apresentação do grande prof. Júlio Neves na BSD Day 2022 sobre shell, ele fez uma comparação interessante sobre shell ser dito lento. E mostrou o seguinte slide:

Eu achei muito interessante o exemplo, mas resolvi testar ele pra valer.

Então testei não com 200 interações, mas com 20 milhões. Daí sim a coisa fica mais interessante.

Fiz o mesmo script em shell:

#! /usr/bin/env bash

for ((i=1; i<20000000; i++)) {

: > arq-shell

}

Em python:

#! /usr/bin/env python3

for i in range(20000000):

with open("arq-python3", "w") as fd:

None

em perl:

#! /usr/bin/env perl

for ($i=0;$i<20000000;$i++) {

open(FD, ">arq-perl");

}

e finalmente em Go:

package main

import (

"log"

"os"

)

func main() {

for i := 0; i < 20000000; i++ {

fd, err := os.Create("arq-go")

fd.Close()

if err != nil {

log.Fatal(err)

}

}

}

Os resultados foram os seguintes:

helio@goosfraba /t/comparacao-shell> time ./20M-touch.sh

________________________________________________________

Executed in 303.69 secs fish external

usr time 164.93 secs 0.00 micros 164.93 secs

sys time 133.79 secs 533.00 micros 133.79 secs

helio@goosfraba /t/comparacao-shell> time./20M-touch.py

________________________________________________________

Executed in 374.49 secs fish external

usr time 225.16 secs 623.00 micros 225.16 secs

sys time 143.90 secs 125.00 micros 143.90 secs

helio@goosfraba /t/comparacao-shell> time ./20M-touch.pl

________________________________________________________

Executed in 173.94 secs fish external

usr time 47.95 secs 1.05 millis 47.95 secs

sys time 122.10 secs 0.00 millis 122.10 secs

helio@goosfraba /t/comparacao-shell> time ./20M-touch

________________________________________________________

Executed in 147.80 secs fish external

usr time 45.82 secs 579.00 micros 45.82 secs

sys time 107.38 secs 113.00 micros 107.38 secs

Eu achei os resultados um pouco miseráveis pra python. Então re-escrevi a função como era feito desde o python 1.2 (usando 3.10.4):

#! /usr/bin/env python3

for i in range(20000000):

fd = open("arq-python3", "w")

fd.close()

e o resultado não melhorou muita coisa.

helio@goosfraba /t/comparacao-shell> time ./20M-touch.py

________________________________________________________

Executed in 370.23 secs fish external

usr time 218.59 secs 641.00 micros 218.59 secs

sys time 146.02 secs 132.00 micros 146.02 secs

Acho que agora os números falam por si só sobre shell ser lento ou não. Claro que pra coisas mais simples é bem mais fácil fazer em shell, mas isso não significa um desempenho melhor.

Tirando essa parte de desafio, a palestra foi espetacular. Quem não viu, recomendo que assistam.

Andei ocupado e escrevendo pouco aqui no site. Parte porque estava preparando uma apresentação sobre Go pra BSD DAY desse ano.

E aqui está a gravação da apresentação.

Como já é a segunda palestra com Go sobre o mesmo assunto, deve também ter sido a última. Resta agora pensar no que vou falar na próxima. Estou trabalhando em alguns projetos pessoais em Go, mas como nenhum chegou num ponto bom de usabilidade, não tenho o que apresentar ainda. Mas vamos ver se consigo avançar.

Como os eventos estão voltando ao modo presencial, também deve ser difícil eu continuar apresentando algo no Brasil. Talvez algo aqui na Europa e muito provavelmente aqui na Suécia. Veremos.

Faz muitos anos eu me inscrevi em sites de emprego. Reflexo da época em que fui demitido da D-Link (longa história que só conto em mesa de bar e acompanhado de muita cerveja).

Mas recentemente eu comecei a receber ofertas... bastante inusitadas.

Essa é até que razoável. Trabalhar pra vendas de alguma startup, mas na região de Ribeirão Preto. Não lá muito próximo de onde eu morava, nem mesmo na área específica em que trabalhava mas...

Promotor de vendas, com abordagem de rua... para primeiro emprego??? As coisas começaram a ficar estranhas. Talvez algo no meu currículo ligue meu perfil com vendas diretamente, uma vez que trabalhei como engenheiro de pré-vendas. Mas promotor de vendas com abordagem de rua?

E novamente auxiliar de vendas. Então acho que os algoritmos encontraram em mim uma carreira que eu nunca fui atrás em desenvolver. Devo ser uma pessoa chave pra vendas.

Espera... o quê!? Caseiro? Eu??? De onde será que o algoritmo tirou isso do meu currículo?

Ajudante geral... nesse ponto eu já acho que algoritmo partiu simplesmente pra zoeira. Só pode ser isso.

E esse foi só um dos e-mails que recebi. Tem vários outros que vão na mesma direção. Um até sugeriu trabalho em uma funerária.

Eu não sei como esse pessoal de sites de empregos fazem esses algoritmos, mas pelo jeito é à base de muita, mas muita, mas muita zoeira.

*Nota: esse artigo foi originalmente escrito pra Revista Espírito Livre, mas como a edição não saiu estou postando aqui.

Olá leitores da Revista Espírito Livre. Eu venho do futuro pra falar sobre os 30 anos de Linux. Futuro muitos anos à frente? Sinto mas estou apenas algumas horas adiantado devido ao timezone em que vivo. Mas tenho um certo prazer em dizer que celebrei a chegada do ano novo antes que todo mundo no Brasil, e avisando o que os aguarda do futuro (geralmente nada). E vamos ser sinceros: no mundo de hoje com tanta gente acreditando em terra plana, rejeitando vacinas e tomando cloroquina, dizer que venho do futuro é até uma licença poética aceitável.

Mas vamos voltar ao assunto do artigo: Linux. E seus 30 anos de vida. Foi uma comemoração bem moderada, sem grandes festas, sem bolo pra comemorar, e nenhuma meetup organizada. Ao menos por aqui. Talvez a culpa fosse da pandemia. Talvez fosse porque Linux já é tão comum e seu uso é diário, o que não nos faz mais sentir que seu aniversário é uma data especial. Mas são 30 anos desde que um estudante finlandês tentou escrever um minix melhor que o minix, um sistema operacional Unix para estudantes, e achou que nunca seria tão grande quanto o projeto GNU.

Não, não vou entrar na polêmica de quem é maior que quem entre GNU e Linux. Ambos têm seus méritos e são gigantes. E não estaríamos onde estamos sem eles. O projeto GNU já completou 38 anos também no dia 27 de setembro, mas o artigo é sobre Linux. Então deixo meus parabéns ao projeto GNU mas tenho de dizer que mesmo o sistema operacional mais comum que usamos pelas distros sendo um GNU/Linux, é Linux que o chamamos. Isso começou desde muito tempo atrás e duvido que mude algum dia. Alguns podem insistir em chamar de GNU/Linux, mas se até mesmo o Debian mudou de Debian GNU/Linux pra simplesmente Debian, que diremos de Linux além, é claro, de apenas Linux? Nomes curtos têm tendência a ficar melhores e as pessoas relacionam-se com isso mais facilmente.

Parte dessa tradição de denominação veio como herança de como eram os sistemas Unix nos princípios dos tempos, ou anos 70 em Unix time. Primeiro existiu o Unix da AT&T, em seguida surgiu uma melhoria desse que ficou conhecida como BSD, de Berkeley. E assim foi por quase 10 anos. O Unix BSD era basicamente o mesmo Unix, mas com drivers, ferramentas, scripts e até sistema de boot de Berkeley. E era o sistema operacional completo, com kernel, bibliotecas, editores, shell, etc. Mesmo os sistemas que surgiram da compra da licença do Unix da AT&T, como SunOS da Sun – atual Oracle, eram sistemas operacionais completos mas com nomes curtos como SunOS, HP-UX, SCO, Xenix, etc.

Quando o bom doutor, Richard Stallman, teve a epifania de criar um sistema operacional totalmente livre, o sistema operacional GNU – pra poder dizer que GNU não era Unix (GNU is Not Unix), nunca pensou em criar tudo de forma coesa. Ele começou da forma simples e em partes. Primeiro as ferramentas: editor (se bem que emacs é mais uma religião que editor mas isso é assunto pra outro artigo bem mais longo que esse), compilador, shell, etc. Mas tudo era separado em seu repositório e era necessário baixar os fontes e compilar sua versão usável. Então nunca houve uma identidade de sistema operacional GNU. Era a biblioteca sunsite com ferramentas GNU. Até surgir o Linux e permitir criar um sistema operacional completo. Claro que pra isso foram necessários os surgimentos das distros, um encurtamento para distribuições, que empacotavam o Linux com GNU e distribuíam como sistema operacional.

E Linux nasceu como um kernel, como já descrevi antes no “um minix melhor que o minix”, mesmo que Tannenbaum discordasse disso, e cresceu tanto em linhas quanto em contribuidores e até mesmo em ecossistema. Hoje em dia Linux é um projeto, uma fundação. E abrange de redes à containers com OCI, Open Container Iniciative. E apesar de ter nascido pra rodar software da GNU como bash e ser compilado com GCC, hoje em dia já roda em sistemas sem nada da GNU como Alpine e Android. E compila com o llvm. Não totalmente como com GCC, mas é um trabalho em andamento e deve em algum momento tornar o Linux compilável com qualquer compilador C. Isso sem comentar o suporte à linguagem rust, que poderá talvez nos próximo 10 anos virar boa parte do código do kernel. Talvez até a maior parte dele. Quem sabe?

Desses 30 anos eu já comentei sobre os surgimento das distros. Falta escrever sobre o desaparecimento delas. Atualmente o site distrowatch, famoso por enumerar as distros que surgiam, parece mais um obituário. A grande maioria das distros que surgiram também sumiram. Não que alguém vá sentir falta da Bieber Linux ou da Hanna Montana Linux, mas sei de gente que até hoje chora a perda do – um momento pra respirar e segurar a náusea – kurumin. A maioria dessas distros recebeu a alcunha carinhosa no Brasil de REFISEFUQUIs. Aqui peço a ajuda ao amigo Fábio Benedito pra descrever o que são:

As REFISEQUIs mostraram um lado interessante sobre a liberdade do software livre: cada um podia e ainda pode fazer um fork de alguma distro e criar a sua própria. Ao contrário das distros que contavam com legiões de voluntários ou funcionários, dependendo se fossem empresas ou projetos voluntários como Fedora e Debian, as REFISEFUQUIs eram batalhas de um soldado só. Talvez dois. Mas não muito mais que isso. Conseguiam fazer o primeiro release, o segundo, então o... o... o... acabava o gás. Talvez algumas tenham ido um pouco mais longe que isso, mas ninguém sobrevive ao tempo sem organização e principalmente mãos pra ajudar a manter tudo funcionando. Talvez o propósito fosse somente ter seu sistema listado na distrowatch. Nesse caso tenho de admitir que a missão foi cumprida. Amigos, amigos, negócios à parte.

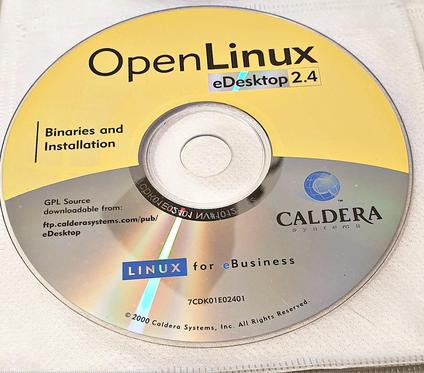

E o que dizer das empresas? Nesses 30 anos muitas delas surgiram pra levar o Linux pra todos como principal sistema operacional do desktop. Inclusive com a versão tupiniquim com a Conectiva. E eram muitas. Infelizmente o cenário atual conta com apenas algumas delas. As que não faliram sofreram um processo de compra ou fusão. E eventualmente faliram. Talvez a venda de software gratuito não fosse tão bom negócio assim? A venda da Red Hat pra IBM por mais de 34 bilhões de dólares dizem o contrário. O que faltou então? Talvez menos geeks programadores e mais pessoas de negócios gerenciando a empresa? Talvez. A verdade é que muita coisa foi feita sem muito planejamento e só imaginando bastasse o software ter licença GPL ou qualquer outra livre e seria o suficiente pra empresa sobreviver. Infelizmente a realidade mostrou que não era bem isso.

E não só de dramas empresariais viveu o Linux nesses 30 anos. Teve também o caso da vira-casaca Caldera Open Linux, que comprou o que sobrou da SCO e aplicou um processo por roubo de propriedade intelectual contra o Linux. O caso ficou anos num tribunal e finalmente teve um fim. Os gestores da massa falida da empresa, que por motivos óbvios não conseguiu sobreviver no negócio, fechou um acordo muito bom de mais de 14 milhões de dólares com a... IBM!? Não me perguntem o porquê da IBM ter sido envolvida em suposto roubo de propriedade intelectual do Linux, mas no fim ela comprou o que sobrou de patentes e propriedade intelectual e encerrou o assunto.

Outro caso de tribunal nesses 30 anos de Linux que ficou muito famoso foi a prisão de Hans Reiser, criador do filesystem reiserfs, um dos primeiros filesystems com journaling no Linux e que eu pessoalmente cheguei a usar, acusado de assassinato. Não que sua prisão tenha alguma relação com Linux. Pelo contrário. Mas foi algo que impactou a direção dos filesystems em Linux, que estavam em suas infâncias no mundo journalling. Depois de sua prisão eu fui movido por, digamos, forças superiores a usar o XFS que foi doado pela SGI ao Linux. E até hoje é meu filesystem predileto, junto com LVM.

Outro drama vivido na lista do kernel durante esses 30 anos foi o eventual sumisso do próprio Linus Torvalds seguido da introdução de um código de conduta,vonde ele mesmo aceitava que tinha um comportamento tóxico e que precisa fazer terapia para endereçar seus problemas de uma melhor maneira. Não faltou gritaria em relação ao código de conduta com ataques dizendo que o mesmo iria coibir a participação das pessoas no desenvolvimento do kernel. Atualmente ninguém questiona o quão benéfico foi esse código de conduta, assim como quão tarde veio a ser adotado. E, claro, ainda há quem diga que ele motivou muita gente a não participar mais do desenvolvimento. Quantos? Esse será um dado que nunca veremos.

E ao longo desses 30 anos do Linux vimos também a grande batalha dos sistemas de inits, onde systemd saiu como vencedor e upstart virou lembrança. De todos os males ditos sobre o systemd na época, poucos realmente aconteceram, se é que aconteceram. E justiça seja feita: systemd é muito, mas muito mais que um mero sistema de init.

Claro que algumas distros seguem longe do systemd, como se isso fosse algum certificado de pureza. Mas nada que abale a realidade de que systemd funciona, vai muito bem obrigado, e trouxe flexibilidade e robustez ao Linux. Se antes precisávamos de gambiarras pra monitorar se um daemon não tinha dado crash e fechado inesperadamente, agora apenas temos o systemd lá monitorando e garantindo tudo funcionando. Ou quase. Claro que aparecem uns problemas aqui e ali, mas nada que negue o fato de que systemd melhorou muito a forma de como Linux tem seus daemons rodando.

crond? Coisa do passado. systemd tem agendamento de tarefas e substitui completamente o crond, que por sua vez poderia ter um crash e simplesmente parar de funcionar. E não para por aí o canivete suíço de funcionalidades do systemd.

E nesses anos vimos como Linux chegou ao mundo dos games. Primeiramente de forma modesta com jogos portados pela Loki games. Depois de um tempo de silêncio e de abandono, uma voltou triunfante com o suporte da Steam, a gigante de jogos digitais.

Mas mesmo a Steam passou por maus bocados. Sua estratégia de abraçar o Linux foi para fugir dos braços da Microsoft, que na época mudava sua visão sobre jogos com o Windows 8, tentando forçar os jogadores a usarem sua própria loja de jogos. Então pra ter massa de manobra e poder negociar, a Steam abraçou o Linux. E lançou seu próprio sistema operacional chamado SteamOS, baseado no Debian. E foi um sucesso. Ou quase isso.

A quantidade de jogadores em sistemas Linux chegou a dobrar de 1 para 2%. Mas não mais que isso. Apesar de todo o suporte, o uso nunca cresceu como esperado.

Mas foi o suficiente pra dar o que a Steam precisava: algo pra negociar e tempo. E com o tempo o CEO da Microsoft foi trocado, e por um que tanto declarou amar Linux, e abraçou definitivamente dentro da empresa, assim como provavelmente chegou num acordo com a Steam. E ficamos sem muitas novidades.

Isso até pouco tempo atrás, quando a Steam anunciou novamente algo bastante interessante: Steam deck. Basicamente um PC portátil com tela e controle conectados que permite jogar em qualquer lugar seu catálogo de jogos e... rufem os tambores... rodando Linux. Dessa vez a escolha foi o Arch Linux, a nova distro do pedaço que todo mundo ama. Eu incluso.

Essa nova estratégia da Steam muda seu foco de apenas ser uma plataforma digital de jogos pra vender console de jogos, competindo com Playstation, Xbox e Nintendo Switch. Por outro lado a maioria dos jogos continuaram não sendo nativos pra Linux, mas rodando através de um wine melhorado da própria Steam, o proton. Se chegou agora e não conhece o wine, esse é um software que faz uma tradução das chamadas de programas Windows para Linux. O resultado disso é a possibilidade de rodar programas feitos para Windows diretamente em Linux. E nisso acho que a mudança da Steam vai dar uma piorada pra jogos nativos em Linux. Que estúdio gastará tempo e pessoal pra fazer um jogo que rode em Linux quando pode fazer em Windows, o que provavelmente já fazem, e apenas trabalhar pra rodar bem em proton? Então é uma vitória com um certo gosto amargo de derrota.

Todo os anos eu além de dizer que estou no futuro na virada do ano, também digo que o próximo ano será o ano do Linux no desktop. E isso já faz uns... 15 anos? Talvez mais. Tanto que sempre uso a famosa imagem/meme do nerd dizendo isso (que aliás nem sei quem é pra dar os devidos créditos).

E esse ano nunca chegou. Não da forma que eu imaginava pelo menos. Atualmente o laptop chromebook é um dos mais vendidos para área de educação tanto nos EUA quanto na Europa. O Brasil não entra na conta por ainda viver um bom atraso tecnológico, mas aqui na Suécia minha filha tem seu chromebook na escola pra pesquisar e fazer os exercícios escolares. Na Suécia não houve um lockdown como em outros países durante a pandemia, mas alunos do colegial pra cima foram solicitados pra estudarem de casa. E cada um levou seu chromebook pra isso. E isso aconteceu em vários outros países, não somente aqui.

Sem contar que muitos desktops e laptops foram trocados por tablets e smartphones. Eu mesmo leio bastante em meu tablet Android e passo as manhãs lendo as notícias no meu smartphone (que diga-se de passagem tem a tela tão grande que praticamente precisei comprar uma calça nova e experimentar antes se ele cabia no bolso), também Android. Então a realidade de desktop que esperávamos não é mais aquela de 15 ou 20 anos atrás. Virou uma realidade de cloud, nas nuvens.

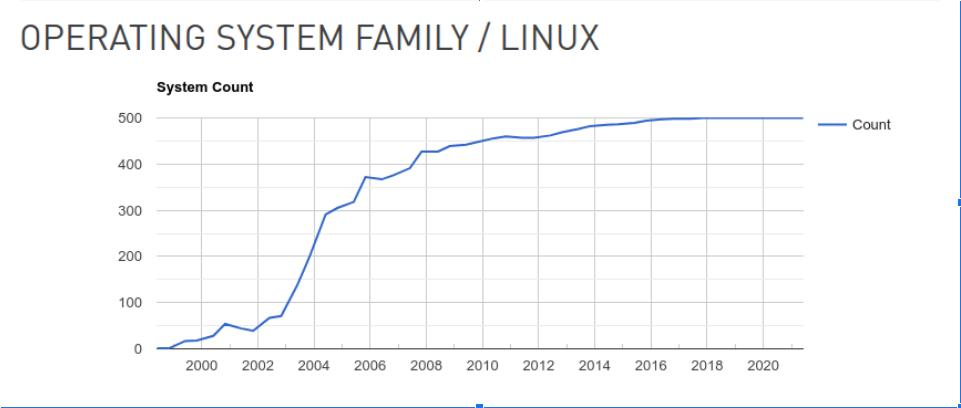

Mesmo que, pra desgosto de alguns, cloud rode no computador dos outros, atualmente é impossível fugir dele. Assim como tablets, smartphones, smartTVs, raspberrypis e muitos outros dispositivos, o cloud roda baseado em Linux. Linux virou o senhor supremo de todas as áreas. De geladeiras a super computadores, sendo presença prepobderante na lista dos 500 mais rápidos super computadores do mundo, sendo liderado atualmente pelo Fugaku do Japão com 7.630.848 núcleos de CPU e impressionantes 537.212 teraflops por segundo de desempenho de pico. Nesse é possível jogar minecraft sem lag.

Mas a discussão é no desktop, aquele ambiente dominado pela Microsoft. Sim, esse mesmo. Estamos em 2021 e ainda hoje as pessoas sofrem com vulnerabilidades e malwares enviados por mail no sistema de Redmond. Praticamente o mesmo problema desde que lançaram o Windows 95. E as pessoas continuam usando mesmo assim. Então eu duvido que Linux consiga entrar nesse mercado onde vírus e ransomware já são tidos como coisas absolutamente normais do dia a dia. Ele ficará naqueles que gostam de ter um sistema melhor, mais rápido e mais seguro.

E a liberdade? Sim, existem aqueles que usarão pela liberdade. E talvez por outros motivos. Mas isso não é importante, mesmo que pra eles sejam. O importante é que usem.

E aqui deixo escrito a mensagem que sempre passei e que sempre indignou muita gente: usem software livre. Não percam tempo com política, liberdade, filosofia, etc. Apenas usem se não for seu caso ainda. Isso abrirá portas para você.

Gostou? Então não fique só na instalação de uma distro. Ou de várias. Linux e outros software livres são baseados em... software. Então entre de cabeça. Aprenda a programar usando shell scripts. Depois vá pra linguagens como perl, python e nodejs. E não pare aí. Entre de cabeça.

Ajude um projeto pois tanto Linux quanto todo o ecossistema de software livre ainda dependem de voluntários, que estão ali pra ajudar e aprender. Então participe. Faça parte. Tenho certeza não se arrependerá.

Finalmente deixo aqui meu viva ao Linux e seus 30 anos.

Hoje é 20 de março e finalmente a temperatura atingiu um nível o suficiente pra abrir as janelas pela primeira vez no ano: 15°C. Peço desculpas pelas manchas de poeira acumalada pelo inverno, mas ainda não foi quente o suficiente pra passar um tempo limpando as janelas pelo lado de fora.

Se chegou aqui e ainda não leu os outros artigos, então pare e leia agora:

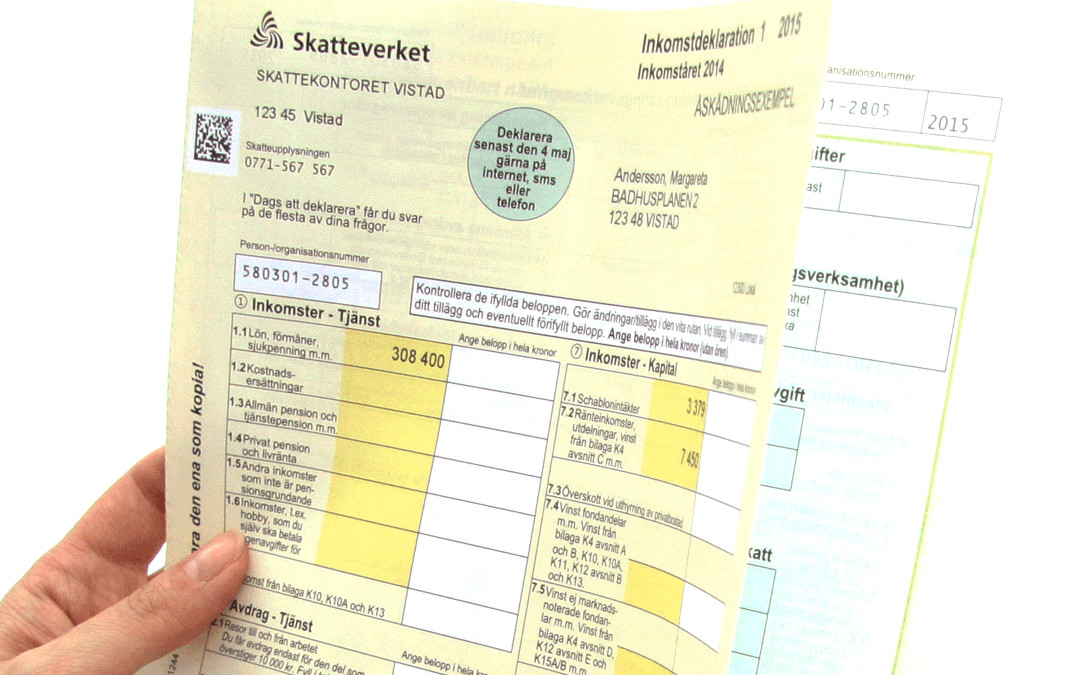

Aproveitando toda a emoção que a primavera traz, também recebemos nosso imposto de renda. O órgão que controla a cobrança de imposto é o mesmo que cuida do registro de pessoas, o skatteverket. Aqui na Suécia nós não fazemos o imposto de renda: ele já vem pronto. Então nos resta apenas confirmar os dados e aceitar. E pronto.

Como tudo é ligado com seu número pessoal aqui, fica fácil pro skatteverket saber qualquer receita que recebeu em sua conta no banco, assim como a gastou. Tudo aqui é registrado.

Você pode alterar o relatório de imposto que recebeu adicionando alguns dados a mais, como serviços de limpeza ou empregada, que emitem um recibo chamado RUT onde 50% do valor pago pelo serviço pode ser deduzido do imposto. Geralmente nem é preciso fazer isso pois o prestador de serviço que emite um RUT pra você já faz o registro junto ao skatteverket. Mas a opção de editar o relatório de imposto de renda existe. Só que qualquer alteração no mesmo já significa que está na malha fina. Emitir nota fiscal amiga? Aqui isso não é possível.

A declaração de imposto de renda pode chegar em forma de papel, como essa da imagem acima ou por formato digital se assim preferir, que é meu caso. Você pode responder que está ok pelo site diretamente, ou pelo correio ou até mesmo por SMS. Eu geralmente faço pela página web. Nenhum plugin adicional é necessário. Só entrar, conferir os dados e olhar se tem algo a pagar ou a receber e enviar.

Ouço isso o tempo todo. Então vamos ao números do meu imposto de renda desse ano. Então no ano passado ou paguei exatamente... rufem os tambores... 26.69%. Contando do que recebi o ano todo e de quanto imposto foi devido.

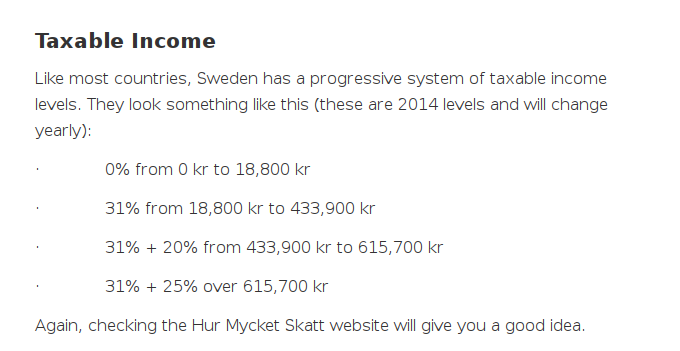

Aqui o imposto é cobrado por faixas salariais como no Brasil, mas tem o imposto progressivo: quanto maior o salário, maior o imposto a ser pago.

Eu não sei bem as faixas como estão hoje em dia, então estou usando a referência daqui: https://everythingsweden.com/tax-in-sweden/

Esse cáculo de 31% depende de onde mora. Se é numa zona com poucos serviços e precisa de desenvolvimento, esse imposto pode chegar à 36%. Como eu moro no subúrbio de Estocolmo, mas ainda parte de Estocolmo, o imposto é mais baixo. É a parte que vai pra manter escolas, dentistas e médicos na sua região diretamente. Então onde o imposto é mais alto o custo de vida é mais baixo, pois é uma região mais afastada. E quanto mais próximo do centro, mais baixo o imposto mas mais alto o custo de vida, incluindo aluguéis.

Algumas coisas que o imposto morde você com força aqui que escorre até uma lágrima quando recebe o salário: horas extras tem 50% de imposto direto em cima do valor pago, "benefícios" pagos pela empresa cobram 50% de imposto em cima, o que inclui até uso de lavanderia em viagem de trabalho e ticket alimentação.

Outro impostos estranhos que são pagos aqui: televisão pública (1300 sek/ano) e tem um imposto-velório, que você tem todo o serviço funerário disponível quando morrer sem precisar de ninguém pagar por nada. Você já pagou durante a vida. Eu não achei quanto é mas é um valor bem baixo.

Update: achei uma referência do imposto de funeral em https://www.scb.se/en/finding-statistics/statistics-by-subject-area/public-finances/local-government-finances/local-taxes/pong/statistical-news/municipal-taxes-2020/

são 25 centavos por mês.

Estão abertas as inscrições para a caravana GNU/Bumba, que levará os interessados, de São Paulo até Porto Alegre, onde ocorrerá o III

Fórum Internacional de Software Livre,nos dias 02, 03 e 04 de Maio. O ônibus (com ar-condicionado e leito) passará também por Curitiba e Florianópolis, para embarque dos companheiros desta região que desejarem

se juntar a caravana. A organização da caravana já reservou as vagas necessárias no Hotel Elevado, que fica próximo à PUC, local onde será realizado o Fórum. O Fórum, http://www.softwarelivre.rs.gov.br/forum/, evento anual que está em sua terceira edição, contará com a presenta de grandes

palestrantes, como Bob Chassell (FSF), Paul Everitt (Zope), Miguel de

Icaza (Ximian), Patrick Stakem (NASA); Shane Hathaway [Python], David

Sugar (GNU Bayonne), Ralf Noldem (kDevelop), Tim Ney (Gnome Foundation);

Andrei Zmievski (PHP-GTK), Peter Salus (Matrix), Larry Wall (Perl) e

Jon "maddog" Hall. Não perca esta oportunidade de ouvir grandes nomes do movimento Software Livre e de conhecer os amigos de todo Brasil que estarão reunindo-se neste evento imperdível! Valores Ônibus: R$ 100,00 (Ida e volta. O ônibus ficará a disposição para nos levar até a PUC todos os dias) Vale lembrar que, quanto mais pessoas, menor o valor. [:)] Hospedagem: As diárias do Hotel Elevado terão um custo de R$ 25,00 (quarto individual) ou R$ 18,00 (duplo). O pagamento do ônibus deverá ser realizado por depósito bancário Wendell Martins Borges

E assim, com essa singela mensagem, Wendell (mais conhecido como perlporter), juntou um bando de nerds numa das melhores e mais divertidas viagens até o FISL, o GNU/Bumba. Todo mundo junto, num ônibus de viagem, falando sobre Linux, FreeBSD, software livre, etc. Foram dias intensos com palestras e workshops, mas sobrevivemos pra estar aqui, 20 anos depois, e contar essa história.

Como toda viagem, começou lenta e sonolenta, pegando recém-chegados de outros estados ou mesmo países na rodoviária do Tietê na capital de São Paulo. E partiu rumo à Porto Alegre, com parada em Curitiba e Florianópolis. Pra animar o pessoal, uma parada pra comprar cerveja. E tudo mudou. Virou um carnaval sobre rodas.

Naquela época eu consegui pegar emprestada a máquina fotográfica do departamento, que usávamos pra fazer site survey. A fotos em resolução 640x480p salvas em disquete são as imagens vistas no vídeo abaixo (tá... eu passei num esquema com machine learning pra aumentar o tamanho das fotos). Grande época, com Larry Wall aparecendo no workshop de perl, pessoal do CIPSGA, Debian Brasil em formação (naquela época era tudo muito dividido por estados com Debian-SP, Debian-RS, etc), SamaBSD e muitos outros.

O SamaBSD foi uma empresa que surgiu pra vender o FreeBSD. E só existiu durante o FISL. Depois disso nunca mais ouvi falar da empresa e não tenho ideia do motivo de não ter ido pra frente.

E durante essa viagem eu já usava FreeBSD no meu laptop. Lembro que fizemos uma competição de quem dava boot mais rápido, eu com FreeBSD, e... acho que era o PH com Debian. Ganhei com larga margem. Na volta já tínhamos convertido boa parte do GNU/Bumba pra BSDBus :D

Das pessoas que aparecem nas fotos e que consegui reconhecer:

E muitos outros que agora não lembro o nome, afinal já se foram 20 anos.

Um grande agradecimento ao Perlporter por ter tido a coragem de organizar essa viagem. Foi realmente inesquecível e muito divertida. Um evento organizado por e-mail numa época em que não nos conhecíamos pessoalmente e sabíamos apenas os ids de cada um. Apesar de tudo, foi algo que mostrou como o software livre era baseado em comunidade.

Valeu tru!

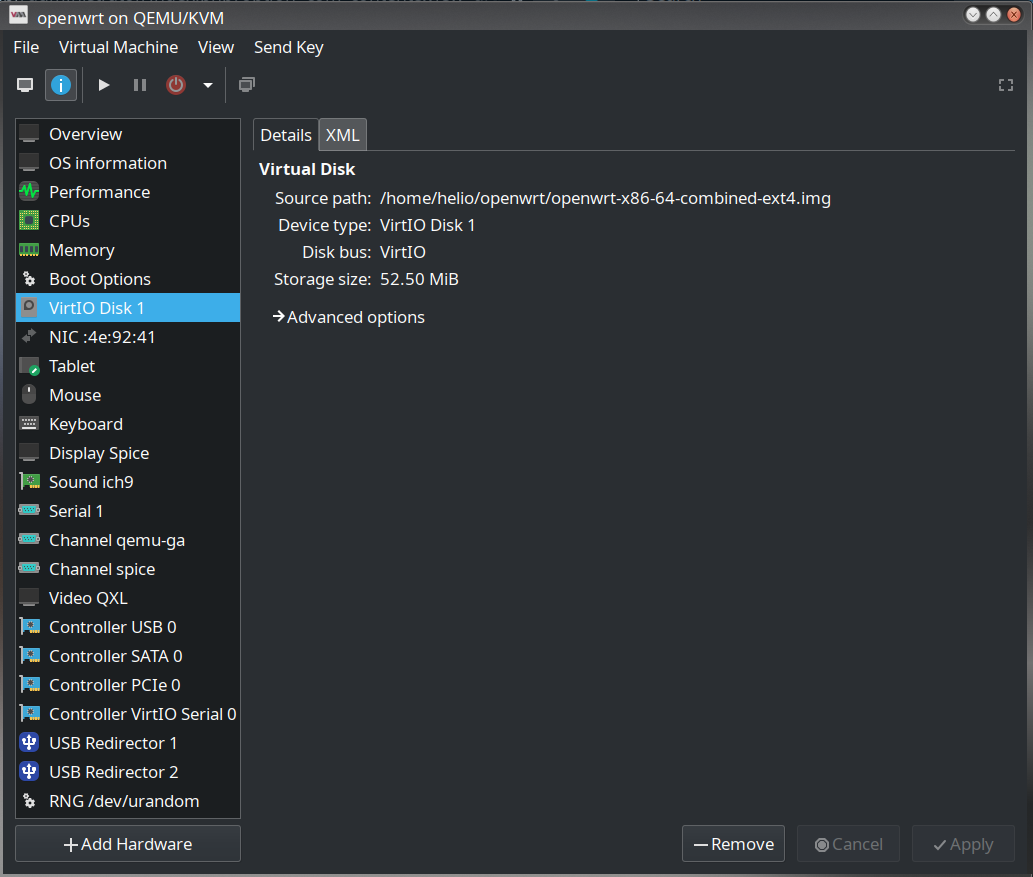

Depois que publiquei o artigo sobre o firewall no openwrt em refatorando meu script de bloqueio de youtube no openwrt, eu ainda precisei dar umas boas mexidas no script pra melhorar. Inclusive comprei até um roteador novo pra poder usar o OpenWRT melhor e com mais facilidade, um Linksys WRT3200ACM que suporta nativamente o OpenWRT. Parece que seu firmware original é até baseado no OpenWRT, mas durou exatamente 5 minutos na minha mão. Só o tempo de conectar e carregar o OpenWRT nele.

O inconveniente é que mexer remotamente em regras de firewall invariavelmente leva a... ficar com a conexão bloqueada. Algumas vezes basta reiniciar mas em outras é preciso rebootar no botão.

Então procurando alguma forma de melhorar meu workflow ao invés de usar o bom e velho XGH, eu acabei achando uma image de VM do openwrt. E instalei aqui usando o libvirt. As imagens ficam aqui:

https://archive.openwrt.org/snapshots/trunk/x86/64/

É um repositório pra x86_64. Eu usei a image openwrt-x86-64-combined-ext4.img.gz, que bastou mapear no virt-manager e usar. Deixei com 2 cpus e 512 MB de RAM, que é a mesma memória disponível no Linksys WRT3200. E isso facilitou bastante mexer com o script. Resolvi um bug que as conexões ficavam ativas quando deveriam estar desabilitadas. Então se for usar meu script, pegue do github pra ter a versão mais atualizada.

E esse foi então o resultado do uso do obamawatcher que descrevi em Obama está observando você durante o ano de 2021.

É possível ver a barba crescendo :)

Se chegou aqui e ainda não leu os outros artigos, então pare e leia agora:

Peço desculpas pelo último artigo sobre o inverno. Mas depois de alguns anos vivendo no frio, gelo e escuridão, eu já estou parecido com o argentino no Canadá. Exceto que não cai pra quebrar nenhum osso ainda, nem bati carro na neve e muito menos penso em voltar pro Brasil.

Eu larguei meu rant sobre o inverno e não comentei de algumas coisas loucas que já fiz aqui nessa época do ano. Teve uma vez que caiu uma tempestade de neve que era prevista ser a pior da última década. Era tipo uma confluência de tempestades de neve juntas com mais uma frente fria chegando e tudo mais. Era algo como o dia que até o inferno congelaria. Chamaram carinhosamente de "a besta do leste", the beast of East.

Sabendo das notícias, eu e meus colegas combinamos de trabalhar no tal dia remotamente. E o que aconteceu? Nada. Não nevou. Ficou tudo ok. Então durante aquele dia decidimos todos ir pra empresa no dia seguinte.

E eu fui de bicicleta.

Só que a tal mega tempestade de neve pegou algum congestionamento na Alemanha e chegou no dia seguinte. E com força. Eu por acaso consegui registrar muita coisa.

Foi até engraçado, mas o ruim foi que nevou muito. Demais. Carros foram soterrados na neve. Quem estava na empresa saiu por volta das 10 horas da manhã porque os carros estavam desaparecendo na neve. E quem saiu nesse horário ficou preso num mega congestionamento, porque estava intransitável. E eu com a minha magrela.

O esforço de pedalar na neve é parecido com o de pedalar em areia fofa (chuto que seja porque nunca tentei andar de bicicleta na praia, mas andando é a mesma sensação, então deve ser também parecido). Cansa. Cada 2 ou 3 pedaladas que eu dava, andava meia pedalada. Mas eu sobrevivi. Fui e voltei ao trabalho numa das piores tempestades de neve dos últimos tempos.

Só que de noite, enquanto eu dormia, simplesmente tive câimbras nas duas batatas das pernas. Eu lá, dormindo e babando, e de repente eu pulo (e caio) da cama gritando de dor com as duas pernas travadas. Dizem que maratonistas novatos têm esse tipo de reação depois do esforço extremo da corrida. Eu precisei trabalhar o restante da semana de casa porque nem andar eu conseguia direito.

Foi louco, mas eu fiz. Acho que maratonistas também sentem a mesma coisa. Tanto de adrenalina e sentido de superação quanto as câimbras. Não sei se faria novamente. Mas como estamos todos em casa por conta da pandemia, então não preciso pensar muito nisso.

E agora um fato que aconteceu esses dias e tirei uma foto pra registrar.

É a mesma foto que abri esse artigo, digo, o mesmo lugar, mas repare nas crianças na plataforma.

Eu esqueci de dizer nos artigos anteriores que as escolas levam as crianças pra excursão usando o transporte público. A pessoa mais na frente é a professora ou professor. E de manhã é bem comum ver um monte de alunos na plataforma do metrô. Em alguns casos eles vão à biblioteca do bairro, que fica a uma estação dessa, em outras vão visitar museus. Sim, museus. Os museus aqui na Suécia, e principalmente em Estocolmo que tem muitos, é um lugar de diversão pras crianças. Eles têm geralmente um parque indoor temático, relacionado à exposição do museu, onde as crianças podem brincar e aprender.

As fotos a seguir são das partes pras crianças brincarem no tekniska museet, museu de tecnologia. O mesmo onde está o primeiro servidor do piratebay.

E enquanto as crianças estão entrando ou saindo do trem do metrô, o maquinista espera. A última pessoa a entrar e sair é o professor. Quando a turma é muito nova, como jardim da infância, eles vão em 2 professores ou então duas turmas de crianças com 4 professores. E sempre tem um que sai ou entra por último e faz sinal pro maquinista que está ok pra ir. E só então o trem fecha as portas e segue. É algo tão, mas tão, mas tão comum aqui que eu esqueci de escrever sobre isso antes.

E agora algo sobre mulheres e maquiagem.

Essa revista chegou hoje. Essa é a típica mulher sueca aqui. Não só pelos olhos azuis e cabelo loiro, mas pela pouca maquiagem. E não existem nenhuma sensualização dela na foto. E apenas ela sendo ela. E confesso que depois de um tempo aqui, passando por essa desintoxicação quanto ao marketing brasileiro e objetificação feminina, eu já acho hoje em dia as propagandas que vejo do Brasil com algo bem vulgar.

E é isso. Guardar energia pra escrever mais na semana que vem. Que com certeza terá mais frio, mas já menos escuridão.

Já é possível ver como melhorou muito o tempo aqui. Peço perdão pelo sarcasmo.

UPDATE 2022-01-22: algumas fotos de como realmente fica tudo em volta durante o inverno, sem o romantismo das bolas de neves. Parte da sujeira é por causa da areia, mostrada numa das fotos, que serve pra dar um pouco de atrito no gelo e tentar ajudar a não escorregar tanto. Mas boa parte do que se vê são os "icepacks", pacotes de gelo. Neve que derreteu e congelou de novo. Tirei as fotos hoje durante minha ida ao restaurante próximo pra comprar o almoço.

Se ainda não leu os artigos anteriores:

Como bons brasileiros, nós não conhecemos neve. Talvez alguns dias frios durante o inverno, um pouco de gelo pra quem viaja pra São Joaquim em Santa Catarina, ou férias de inverno em Bariloche pros mais abastados. Então é uma visão romântica da neve e do inverno.

Inverno é duro aqui. Muito duro. Começa a ficar frio por volta de meados de setembro e só volta a melhorar em meados de abril. Mas em alguns anos isso só aconteceu em julho (e também teve anos em que março estava bom). Então vivemos com as janelas fechadas por 5 ou 6 meses por ano. Janelas com vidro duplo, pra isolar o ambiente. Dentro de casa vivemos em confortáveis 21°-25° C dependendo dos radiadores e da casa. Em geral perto de 21° C.

Não bastasse o frio, uma das piores coisas aqui na europa nórdica é a escuridão. A foto acima do sol pondo-se foi feita por volta das 3 horas da tarde. Nessa época do ano o sol nasce depois das 8 da manhã. Hoje, dia 15 de janeiro, o sol nasce às 8:30 e põe-se às 3:24 da tarde. O ápice a escuridão é dia 21 de dezembro, e depois disso vai aumentando as horas de sol. 1 minuto mais ou menos por dia (em certo momento é bem mais, mas não vou entrar nesse assunto).

Nos primeiros anos recebemos isso como novidade e até adoramos. Afinal é novidade. Mas conforme o tempo vai passando, e isso vira sua rotina, começa a afetar você. Em geral levando à depressão. E esse é um dos maiores motivos de uso de antidepressivos aqui, do qual também sou usuário: regular o corpo com os ciclos de pouco sol no inverno e muito sol no verão. É bem comum encontrar pessoas que passam pelo problema de insônia, que é um dos efeitos disso. Durante o inverno, o isolamento em casa também vira uma norma. E isso traz ainda o que é conhecido como S.A.D., Seasonal Affective Disorder, que é uma forma de depressão.

Esse ano a cervejaria BrewDog fez uma campanha de cerveja pra ajudar as pessoas que sofrem de S.A.D. de tão grave e comum que isso é na europa como um todo (talvez não tanto na parte sul como Grécia, Itália e Portugal). Os lucros arrecadados serão destinados ao tratamento dessa desordem e doenças mentais.

https://www.brewdog.com/uk/iamwhole

A primeira coisa que temos que fazer pra combater o S.A.D. é aumentar a dose de vitamina D, aquela que conseguimos pelo sol. Aqui é item obrigatório entre meados de setembro até meados de março ou até mesmo abril. Adultos e crianças. Mas mesmo não tendo S.A.D., os efeitos do pouco sol fazem-se sentir logo mesmo com a vitamina D extra: cabelos caindo e unhas quebrando. Mesmo os animais de estimação perdem bastante pelos durante o inverno, a ponto de eu achar que consegueria montar um gato a mais por mês com tanto pelo que o roomba coletava (roomba, o robôzinho que varre o chão).

Além do pouco sol, insônia, cabelos caindo, unhas quebrando ainda existe um outro problema com o inverno que é a pele. A pele sofre e muito com o clima frio, que é muito seco. Então uma das coisas que temos de abandonar aqui até certo ponto é banho. É comum ouvir falar de gente que foi ao médico ver uma irritação na pele que estava ficando vermelha, meio esfolada, e o médico perguntar "está tomando banho todo dia?". A água aqui tem muito calcário, tanto que deixa umas manchas brancas por onde seca. Essa mesma água usada diariamente vai deixando a pele cada vez mais seca. Ao ponto de exigir usar cremes hidratantes.

Eu costumo ou usar esse creme, que não tem cheiro e é bom pra quem é alérgico a quase tudo como eu, ou uso um Dove cream shower após tomar banho. E tem quem tome até dois banhos por dia e não tenha esses problemas de pele. Mas quem não cuida e insiste pode desenvolver o que é conhecido como "alergia ao inverno", que é o pior ponto onde pode-se chegar. Essa alergia é uma eczema da pele que fica irritada com qualquer coisa sintética. Então imagine como é terrível enfrentar de 5 a 6 meses de inverno sem poder usar uma jaqueta. E o uso de roupas de algodão, que é a única coisa possível de usar quando se está com a pele assim, têm o incoveniente de perder muito calor. Ao suar, a roupa de algodão fica molhada e não seca, tanto que não é recomendado seu uso.

Então parte do ritual de enfrentar um inverno tão longo é acostumar a usar roupas que permitam que sue, mas o suor fique isolado fora do corpo e ainda assim te mantenham aquecido. Por conta disso as roupas de inverno não cheiram lá muito bem pra narizes recém chegados. Claro que com o tempo a gente acostuma.

Só uma curiosidade sobre os próprios suecos. Como eu costumava ir trabalhar de bicicleta mesmo durante o inverno, claro que dividi vestiário com vários colegas e pude notar seus hábitos quanto ao banho. Existiam alguns que só se enxugavam o suor e colocavam a roupa de trabalho (porque aqui tem de usar uma roupa própria pra pedalar durante o inverno), mas a grande maioria tomava o "banho sueco" que é basicamente entrar no chuveiro e só passar um água rápida. Menos de 5 minutos. Sem sabão. Sim, deixar a pele oleosa. Isso ajuda a pele a sobreviver à rotina do inverno.

Eu comentei acima que dentro de casa as temperaturas são de 21 à 25°C. Recomendam então usar pouca ou nenhuma roupa dentro de casa pra justamente a pele respirar. Por isso é tão comum ver gente andando pelada nos apartamentos no centro da cidade. No começo você acha engraçado e fica um pouco envergonhado com isso, mas depois de um tempo você vira mais um dos pelados andando pela casa.

Mas e a parte legal, de esquiar, patinar no gelo, bonecos de neve, etc?

Claro que isso existe. E é bem divertido. Mas em geral só é possível um ou dois dias depois que nevou, ou em alguns parques enquanto a temperatura ficar abaixo de zero e não tiver muito sol, o que é comum durante o inverno. Nos locais de muita circulação a neve vira uma lama que suja tudo por onde se anda (e daí o hábito na Suécia de não se usar sapatos dentro de casa, nem as visitas).

Esquiar já é algo diferente. Eu nunca fiz, mas as estações de esqui ficam em sua maioria em locais onde a neve cai o ano inteiro. Então é mais ou menos ter vontade de ir lá fazer. Eu até hoje não fui, mas algum dia tento. Quero experimentar o snowboard.

A neve dá uma alegrada na escuridão nórdica, mas por outro lado cria o problema de que escorrega. E muito. O sol bate na neve, que reflete a luz e aumenta a troca de calor. A parte de cima da neve esquenta e derrete. Mas assim que o sol se vai, essa parte de cima congela novamente e vira gelo. Uma área gigantesca de gelo. E no escuro. Os carros e mesmo as bicicletas aqui usam pneus de inverno, que em geral têm cravos de metal pra segurar nesse gelo. Mas não os sapatos. Aliás até tem umas garras que podem adaptar nos sapatos pra andar no gelo, mas é complicado andar com aquilo por aí. Se for ao mercado por exemplo, na rua estará super seguro de escorregar no gelo mas ao entrar no mercado o piso liso vai fazer você escorregar. Então não é algo muito prático pra se usar durante todo o inverno. Talvez pra uma caminhada nos bosques. Então durante o inverno é comum as pessoas caírem e quebrarem braços, pernas, pulsos, etc. Imagine você ter caído num inverno e quebrado a perna? E imagine o medo de acontecer de novo. E ter 6 meses de inverno todo ano.

Em lugares mais urbanos como o centro da cidade é comum passar um tratorzinho nas calçadas limpando a neve e o gelo. O mesmo acontece nas ruas e vias de bicicletas. Claro que eles não limpam o tempo todo. Vez ou outra, numa tempestade forte de neve, fica tudo coberto de neve, que é onde fica o perigo de escorregar e cair. Outro perigo é a neve ou gelo acumulado nos telhados de prédios. Existe o risco de um pedaço grande cair na sua cabeça, assim como aqueles pingentes de gelo que ficam nas beiradas. A recomendação é não andar perto das paredes pra evitar isso. Mas todo ano morrem pessoas assim.

E a roupa de inverno? Todos os lugares onde frequentamos têm aquecimento, e por isso não usamos tanta roupa pra segurar o frio como no Brasil. Geralmente uma boa jaqueta basta. Só que essa jaqueta será seu melhor companheiro por 6 meses por ano. Bom... talvez nem tanto. Frio mesmo faz normalmente em janeiro e em fevereiro. Então digamos de 2 a 3 meses. Mas nos outros meses está frio, abaixo de 10°C. Enquanto uma boa jaqueta dá conta do recado, a maioria tem jaquetas de meia estação, que é também meu caso. São jaquetas que aguentam bem até uns -1 ou -2 °C. Abaixo disso, daí sim a jaqueta de inverno. E não dá pra lavar essa jaqueta a cada uso porque ainda mais no inverno não vai secar tão rápido e sair com jaqueta úmida por dentro não é lá uma boa ideia. Lembram que comentei do cheiro da roupa aqui? Pois é...

Aqui é comum ter muitas promoções boas de roupa de inverno no começo da primavera, por volta de março e abril. Foi quando comprei essa jaqueta da foto. Meu único arrependimento dessa jaqueta foi ter escolhido o branco. Agora ela está toda encardida e não tem jeito de tirar.

Quando cheguei do Brasil eu sentia muito frio em temperaturas de 5°C pra baixo. Eu usava uma camada a mais de roupa, a tal segunda pele ou camada básica. Essa é uma malha a mais de algodão ou sintética, que ao contrário da roupa pra exercício pode ser de algodão (desde que não sue muito nela). Depois de alguns anos morando aqui eu já não uso tanto até temperaturas até -5°C. Só a calça jeans já tá bom o suficiente. Mas isso também depende de quanto tempo estarei fora de casa. Se for pra como por exemplo andar até à praia, onde tirei a foto do início do artigo, com certeza uso sim. São uns bons 30 a 40 minutos de caminhada na neve até chegar lá. E a calça jeans só não segura o frio assim por tanto tempo. Pra ir pro trabalho de transporte público? Só a calça jeans mesmo.

Vendo essa perspectiva de como funciona a vida no inverno aqui, acho que fica claro o motivo do Linus Torvalds ter criado um kernel. É o que se tem pra fazer aqui durante o inverno. Eu tento passar o tempo fazendo pizzas, pães, e cerveja. Jogando PlayStation com os amigos e atualizando aqui o blog. Mas mesmo assim... o inverno é longo. Não acho que consigo criar um kernel, mas tenho feito muitas outras coisa. E dá pra entender o porquê do R. R. Martin usar a Suécia como referência em seus livro do game of thrones. Aqui a gente sempre sabe que o inverno está chegando...

Esse ano eu consegui montar uma retrospectiva logo no ínicio do ano.

Infelizmente foi um final de ano difícil pra mim com a morte do nosso gato de estimação bem no final do ano. Mas... a vida segue.

Eu tinha colocado uma meta de escrever semanalmente aqui no site. Não cheguei a alcançar a meta semanal mas definitivamente escrevi muito mais que nos anos anteriores. É sempre bom adicionar conteúdo.

Montando o vídeo de retrospectiva eu percebi o quão pouco tirei fotos ou fiz vídeos durante 2021. Não sei bem explicar o motivo, mas eu mesmo não lá muito de fazer selfies. E mesmo minha conta no Instagram é mais pra postar fotos em uso a câmera e dou um tratamento melhor que as imagens feitas pelo telefone.

Eu não coloquei uma meta pra participar de eventos com palestras, mas acabei até que fazendo bastante. Foram 4 palestras em 3 eventos:

E ainda fui parte da organização da PyCon Suécia. Não fiz nenhuma palestra lá, mas organizar o evento tomou bastante meu tempo e dedicação. Apareceu uma foto minha nos créditos finais, o que já é suficiente.

Não bastasse isso ainda fui organizador da hackathon global de outono na empresa. Em geral temos 2 por ano. E como é algo interno, eu não fiz muita propaganda fora da empresa. Mas foi mais uma coisa pra eu ter de trabalhar.

Eu acho que desse lado pessoal foi um ano muito bom. Espero conseguir fazer as mesmas coisas agora em 2022. Um pouco menos dessa vez porque quase tudo caiu junto entre meados de outubro e meados de novembro. Inclusive escrevi até um artigo pra REL (Revista Espírito Livre) que não foi publicado. Eu provavelmente vou publicar aqui em algum momento.

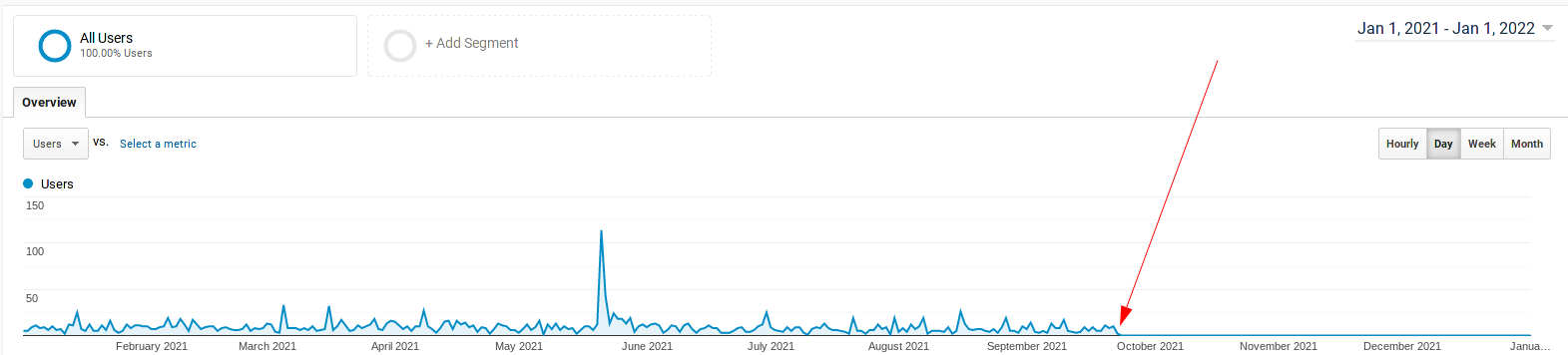

Agora vamos às estatísticas do site. Pra começar uma bela surpresa que só vejo quando faço essa restrospectiva:

Eu fiz alguma besteira no site e o Google analytic parou de funcionar no início de outubro. E não tenho ideia do que possa ter sido. Mas quando acabar de escrever aqui eu já vou dar uma olhada. Sendo estatísticas, vamos chutar que é uma amostra grande o suficiente pra estimar o restante em termos de porcentagens.

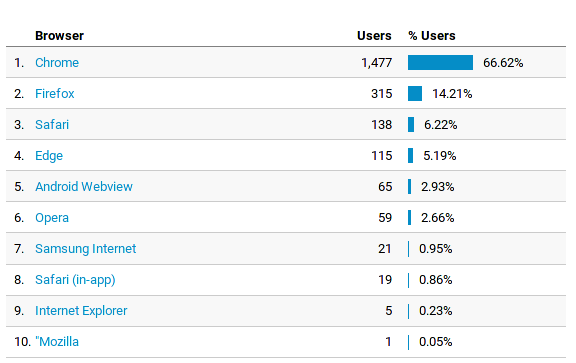

Em relação aos navegadores que mais acessaram:

Chrome já na frente de longe com Firefox em segundo. Eu fiquei feliz de ver o Firefox ainda relevante por aqui.

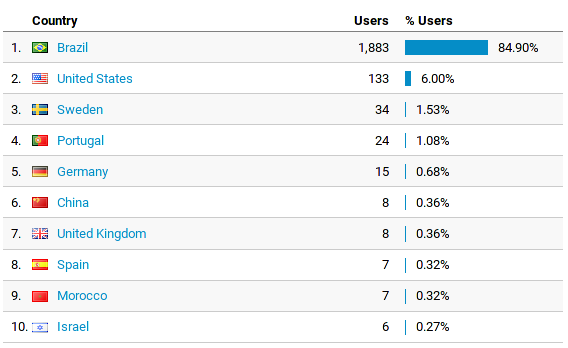

E relação aos países que mais acessaram:

Posso assumir que os 1.34% de acesso a partir da Suécia seja eu mesmo.

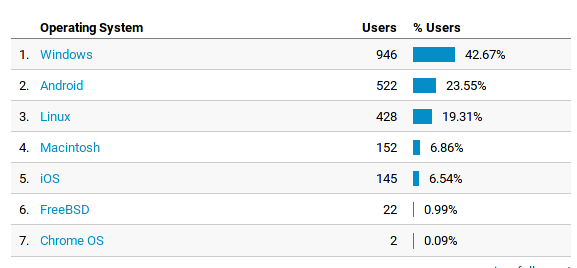

Em relação aos sistemas operacionais de computadores (porque tem uma categoria separada para mobile):

Novamente Windows em primeirão. Acho que pela primeira vez abaixo dos 50%, com android e Linux chegando à uns 42%, que já deixa equilibrado em Linux em Windows. Não me perguntem o porquê do Analytics mostrar separado.

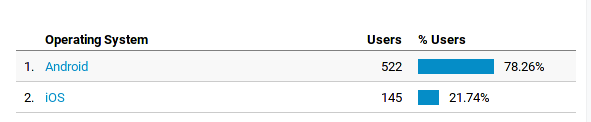

E finalmente os sistemas operacionais mobile:

Quase mesma estatísticas mundial de 85% de equipamentos Android (telefones e tablets). Não muita surpresa aqui. E nada de Windows phone felizmente. Pelo menos na área mobile o povo aprendeu.

E esse foi o resumo do meu 2021. Vou tentar manter o ritmo de 1 artigo ou mais por semana esse ano também. Afinal escrever tem de ser uma rotina ou do contrário as redes sociais roubam todo o meu tempo livre.

Feliz 2022!

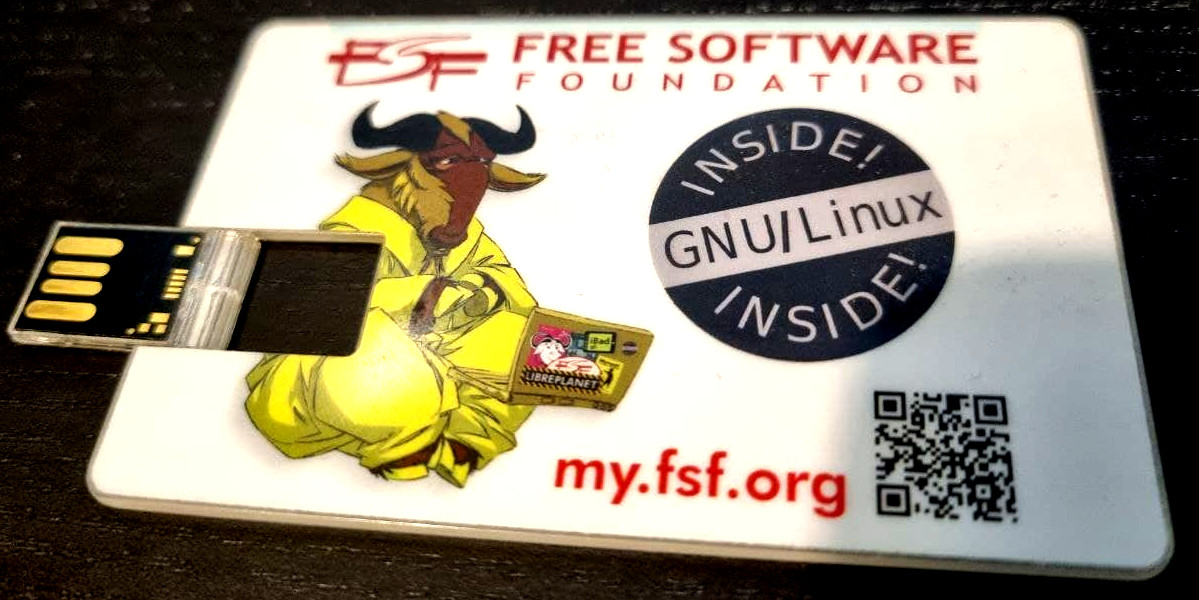

No artigo a era do Arch Linux eu esqueci de comentar, mas segue aqui a menção honrosa ao cartão pendrive da FSF que funcionou maravilhosamente pra instalar o Arch. Uma pena que eles não mencionem o suporte ao Arch, assim como não o fazem pro Debian, em usa página de Free distros. O Arch não instala nada pra você. Nem sugere. Mas já faz anos que a FSF adotou uma postura anti-liberdade, onde o bloqueio de uso de firmwares têm de ser forçado goela abaixo do usuário pra ser aprovada. Espero que isso mude em 2022 na FSF.

Page 11 of 38