Eu descrevi o uso do sensor temper com raspberrypi no artigo

monitorando a temperatura da sala dos servidores.

O que eu não contei ali foi que eu passei a monitorar outros parâmetros mostrado pelo programa sensor.

O sensor faz parte do pacote lm-sensor no Ubuntu.

Rodando o programa com parâmetro -j mostra a saída em format JSON.

❯ sensors -j

{

"coretemp-isa-0000":{

"Adapter": "ISA adapter",

"Package id 0":{

"temp1_input": 61.000,

"temp1_max": 100.000,

"temp1_crit": 100.000,

"temp1_crit_alarm": 0.000

},

"Core 0":{

"temp2_input": 52.000,

"temp2_max": 100.000,

"temp2_crit": 100.000,

"temp2_crit_alarm": 0.000

},

"Core 4":{

"temp6_input": 54.000,

"temp6_max": 100.000,

"temp6_crit": 100.000,

"temp6_crit_alarm": 0.000

},

"Core 8":{

"temp10_input": 61.000,

"temp10_max": 100.000,

"temp10_crit": 100.000,

"temp10_crit_alarm": 0.000

},

"Core 9":{

"temp11_input": 61.000,

"temp11_max": 100.000,

"temp11_crit": 100.000,

"temp11_crit_alarm": 0.000

},

"Core 10":{

"temp12_input": 61.000,

"temp12_max": 100.000,

"temp12_crit": 100.000,

"temp12_crit_alarm": 0.000

},

"Core 11":{

"temp13_input": 61.000,

"temp13_max": 100.000,

"temp13_crit": 100.000,

"temp13_crit_alarm": 0.000

},

"Core 12":{

"temp14_input": 59.000,

"temp14_max": 100.000,

"temp14_crit": 100.000,

"temp14_crit_alarm": 0.000

},

"Core 13":{

"temp15_input": 59.000,

"temp15_max": 100.000,

"temp15_crit": 100.000,

"temp15_crit_alarm": 0.000

},

"Core 14":{

"temp16_input": 59.000,

"temp16_max": 100.000,

"temp16_crit": 100.000,

"temp16_crit_alarm": 0.000

},

"Core 15":{

"temp17_input": 60.000,

"temp17_max": 100.000,

"temp17_crit": 100.000,

"temp17_crit_alarm": 0.000

}

},

"thinkpad-isa-0000":{

"Adapter": "ISA adapter",

"fan1":{

"fan1_input": 2191.000

},

"CPU":{

"temp1_input": 59.000

},

"GPU":{

ERROR: Can't get value of subfeature temp2_input: Can't read

},

"temp3":{

"temp3_input": 59.000

},

"temp4":{

"temp4_input": 0.000

},

"temp5":{

"temp5_input": 59.000

},

"temp6":{

"temp6_input": 59.000

},

"temp7":{

"temp7_input": 59.000

},

"temp8":{

ERROR: Can't get value of subfeature temp8_input: Can't read

}

},

"ucsi_source_psy_USBC000:001-isa-0000":{

"Adapter": "ISA adapter",

"in0":{

"in0_input": 0.000,

"in0_min": 0.000,

"in0_max": 0.000

},

"curr1":{

"curr1_input": 0.000,

"curr1_max": 0.000

}

},

"BAT0-acpi-0":{

"Adapter": "ACPI interface",

"in0":{

"in0_input": 12.909

},

"power1":{

"power1_input": 0.000

}

},

"iwlwifi_1-virtual-0":{

"Adapter": "Virtual device",

"temp1":{

"temp1_input": 42.000

}

},

"ucsi_source_psy_USBC000:002-isa-0000":{

"Adapter": "ISA adapter",

"in0":{

"in0_input": 0.000,

"in0_min": 0.000,

"in0_max": 0.000

},

"curr1":{

"curr1_input": 3.000,

"curr1_max": 0.000

}

},

"nvme-pci-0200":{

"Adapter": "PCI adapter",

"Composite":{

"temp1_input": 44.850,

"temp1_max": 85.850,

"temp1_min": -273.150,

"temp1_crit": 86.850,

"temp1_alarm": 0.000

},

"Sensor 1":{

"temp2_input": 47.850,

"temp2_max": 65261.850,

"temp2_min": -273.150

},

"Sensor 2":{

"temp3_input": 44.850,

"temp3_max": 65261.850,

"temp3_min": -273.150

}

},

"acpitz-acpi-0":{

"Adapter": "ACPI interface",

"temp1":{

"temp1_input": 59.000

}

}

}

Essa saída de comando é do laptop de trabalho, onde estou escrevendo esse artigo.

É possível ver que aparecem alguns erros como ERROR: Can't get value of subfeature temp2_input: Can't read

e que alguns dados não tem valor como em { "coretemp-isa-0000":{ "Adapter": "ISA adapter" } }.

Quando fiz pro servidor, eu acabei meio que escrevendo o código na mão.

sensors = shellExec("/usr/bin/sensors -j")

logger.debug(f"sensors: {sensors}")

jResp = json.loads(sensors)

resp = list()

resp.append("#HELP server_board_temperature_celsius the server board current temperatures")

resp.append("#TYPE server_board_temperature_celsius gauge")

device_1 = "nvme-pci-2b00"

device_2 = "k10temp-pci-00c3"

composite = jResp[device_1]["Composite"]["temp1_input"]

logger.info(f"device: {device_1}, composite, temperature: {composite}")

resp.append("server_board_temperature_celsius{device=\"" + device_1 + "\",sensor=\"composite\"} " + "%0.2f" % composite )

sensor_1 = jResp[device_1]["Sensor 1"]["temp2_input"]

resp.append("server_board_temperature_celsius{device=\"" + device_1 + "\",sensor=\"sensor_1\"} " + "%0.2f" % sensor_1 )

sensor_2 = jResp[device_1]["Sensor 2"]["temp3_input"]

resp.append("server_board_temperature_celsius{device=\"" + device_1 + "\",sensor=\"sensor_2\"} " + "%0.2f" % sensor_2 )

tctl = jResp[device_2]["Tctl"]["temp1_input"]

resp.append("server_board_temperature_celsius{device=\"" + device_2 + "\",sensor=\"tctl\"} " + "%0.2f" % tctl )

tccd3 = jResp[device_2]["Tccd3"]["temp5_input"]

resp.append("server_board_temperature_celsius{device=\"" + device_2 + "\",sensor=\"tccd3\"} " + "%0.2f" % tccd3 )

tccd5 = jResp[device_2]["Tccd5"]["temp7_input"]

resp.append("server_board_temperature_celsius{device=\"" + device_2 + "\",sensor=\"tccd5\"} " + "%0.2f" % tccd5 )

resp.append("")

Então essa semana eu gastei um tempo pra fazer um script mais genérico.

Aparecem agora todos os dados que saem com valor no comando sensor -j, mas em contrapartida não sei exatamente o que são.

Sem mais delongas, aqui o código:

#! /usr/bin/env -S uv run --script

#

# /// script

# dependencies = [

# "uvicorn",

# "fastapi"

# ]

# ///

import argparse

import sys

import subprocess

import logging

import json

import re

from fastapi import FastAPI

from fastapi.responses import PlainTextResponse

import uvicorn

DEFAULTS = {"port": 9090, "path": "/metrics"}

__version__ = "0.1.0"

logger = logging.getLogger(__file__)

consoleOutputHandler = logging.StreamHandler()

formatter = logging.Formatter(

fmt="[%(asctime)s] (%(levelname)s) %(message)s", datefmt="%Y-%m-%d %H:%M:%S"

)

consoleOutputHandler.setFormatter(formatter)

logger.addHandler(consoleOutputHandler)

logger.setLevel(logging.INFO)

def shellExec(command: str) -> str:

"run a command and return its output"

try:

# result = subprocess.getoutput(command, errors=subprocess.DEVNULL)

result = subprocess.check_output(

command, stderr=subprocess.DEVNULL, encoding="utf-8"

)

logger.debug(f"shellExec: {result}")

return result

except Exception as e:

logger.error(f"Error executing shell command '{command}': {e}")

return f"Error: {e}"

class SensorMetrics:

open_metrics: dict = {}

def generateMetrics(self) -> list:

self.dataReset()

sensors_output = shellExec(["sensors", "-j"])

logger.debug(f"sensors: {sensors_output}")

sensorsJSON = json.loads(sensors_output)

# sensorsJSON = {

# "thinkpad-isa-0000": {

# "Adapter": "ISA adapter",

# "fan1": {"fan1_input": 2786.000},

# "CPU": {"temp1_input": 69.000},

# "GPU": {},

# "temp3": {"temp3_input": 69.000},

# "temp4": {"temp4_input": 0.000},

# "temp5": {"temp5_input": 69.000},

# "temp6": {"temp6_input": 69.000},

# "temp7": {"temp7_input": 69.000},

# "temp8": {},

# }

# }

self.getOpenMetrics([], sensorsJSON)

return []

def dataReset(self):

self.open_metrics = {}

def getOpenMetrics(self, header: list, data_dict: dict):

if isinstance(data_dict, dict):

for k, v in data_dict.items():

logger.debug(f"k={k}, v={v}")

if isinstance(v, dict):

self.getOpenMetrics(header + [k], v)

else:

logger.debug(

f"Value is not dictionary: header={header}, k={k}, v={v}"

)

try:

v = float(v)

except ValueError:

logger.debug(f"invalid value: {v}")

continue

metric_head = self.generateMetricHeader(header, k)

metric_description = " ".join(header)

metric_description += f" {k}"

if metric_head in self.open_metrics:

logger.error(f"metric name '{metric_head}' already exists")

self.open_metrics[metric_head] = {

"value": v,

"description": metric_description,

}

logger.debug(

f"Adding: metric_head={metric_head}, value={v}, description='{metric_description}'"

)

else:

logger.debug(f"Not dictionary: header={header}, data_dict={data_dict}")

def generateMetricHeader(self, header: list, key: str) -> str:

metric_header = "_".join(header)

metric_header = re.sub(" ", "_", metric_header)

return f"{metric_header}_{key}"

if __name__ == "__main__":

parse = argparse.ArgumentParser(

description="Script to expose the sensors as open metrics"

)

parse.add_argument(

"--port", type=int, default=DEFAULTS["port"], help="Port to listen"

)

parse.add_argument(

"--path", default=DEFAULTS["path"], help="The path to serve the metrics"

)

parse.add_argument(

"--version",

action=argparse.BooleanOptionalAction,

help="Print version and exit",

)

parse.add_argument(

"--printout",

action=argparse.BooleanOptionalAction,

help="Print the exposed metrics found in the system",

)

parse.add_argument("--loglevel", default="info", help="Logging level")

args = parse.parse_args()

if args.loglevel != "info":

logger.setLevel(args.loglevel.upper())

if args.version is True:

print(sys.argv[0], __version__)

sys.exit(0)

if args.printout is True:

mts = SensorMetrics()

mts.generateMetrics()

for k, v in mts.open_metrics.items():

description = v["description"]

print(f"#HELP {k} {description}")

print(f"#TYPE {k} gauge")

print(f"{k}: {v['value']}")

sys.exit(0)

app = FastAPI()

@app.get(args.path, response_class=PlainTextResponse)

async def metrics():

logger.info(f"serving web page on {args.path}")

mts = SensorMetrics()

mts.generateMetrics()

resp = list()

for k, v in mts.open_metrics.items():

description = v["description"]

resp.append(f"#HELP {k} {description}")

resp.append(f"#TYPE {k} gauge")

resp.append(f"{k}: {v['value']}")

return "\n".join(resp)

logger.info(f"starting service on port {args.port}")

uvicorn.run(app, host="127.0.0.1", port=args.port)

O código pode ser encontrado aqui:

Como pode ser visto no cabeçalho:

#! /usr/bin/env -S uv run --script

#

# /// script

# dependencies = [

# "uvicorn",

# "fastapi"

# ]

# ///

abracei com força a dica do querido Riverfount, que mostrou que o uv podia fazer isso.

E passei a adotar o pacote logging ao invés de enviar prints pro terminal.

logger = logging.getLogger(__file__)

consoleOutputHandler = logging.StreamHandler()

formatter = logging.Formatter(

fmt="[%(asctime)s] (%(levelname)s) %(message)s", datefmt="%Y-%m-%d %H:%M:%S"

)

consoleOutputHandler.setFormatter(formatter)

logger.addHandler(consoleOutputHandler)

logger.setLevel(logging.INFO)

Eu sempre amarro esse singleton de logging, logger, com função do argparse pra poder modificar

o nível.

Começo sempre com info, mas usando o parâmetro --loglevel=debug eu mudo pro nível debug.

Torna prático e flexível pra gerenciar logs de funcionamento.

Além disso o logging usa STDERR pra enviar as mensagens.

Olhando agora pra parte de execução do script shell, onde sensors -j é chamado:

def shellExec(command: str) -> str:

"run a command and return its output"

try:

# result = subprocess.getoutput(command, errors=subprocess.DEVNULL)

result = subprocess.check_output(

command, stderr=subprocess.DEVNULL, encoding="utf-8"

)

logger.debug(f"shellExec: {result}")

return result

except Exception as e:

logger.error(f"Error executing shell command '{command}': {e}")

return f"Error: {e}"

Uso como função ao invés de método da classe. Acho que fica mais simples. E poder rodar script do shell dentro de uma classe não parece lá muito como uma propriedade da classe em si.

Notem que inicialmente eu tentei usar subprocess.getoutput( ).

O problema são aquelas mensagens de erros que eu comentei acima,

ERROR: Can't get value of subfeature temp2_input: Can't read,

que saem junto.

Isso quebra a chamada do json.loads( ).

Tentei usar o parâmetro errors=subprocess.DEVNULL, mas aparentemente o subprocess.getoutput( ) não herda isso.

Então não funciona.

O jeito foi usar subprocess.check_output( ).

A grande diferença é que o primeiro aceita string, então poderia usar simplemente "sensors -j" como argumento.

No subprocess.check_output( ), o parâmetro precisa ser uma lista.

Tem de ser passado como ["sensors", "-j"] que não é o fim do mundo, só um pouco mais chato.

A classe SensorMetrics está bem simples de entender no começo.

Acho que a única parte que precisa de um pouco mais de cuidado pra olhar é o método getOpenMetrics( ).

def getOpenMetrics(self, header: list, data_dict: dict):

if isinstance(data_dict, dict):

for k, v in data_dict.items():

logger.debug(f"k={k}, v={v}")

if isinstance(v, dict):

self.getOpenMetrics(header + [k], v)

else:

logger.debug(

f"Value is not dictionary: header={header}, k={k}, v={v}"

)

try:

v = float(v)

except ValueError:

logger.debug(f"invalid value: {v}")

continue

metric_head = self.generateMetricHeader(header, k)

metric_description = " ".join(header)

metric_description += f" {k}"

if metric_head in self.open_metrics:

logger.error(f"metric name '{metric_head}' already exists")

self.open_metrics[metric_head] = {

"value": v,

"description": metric_description,

}

logger.debug(

f"Adding: metric_head={metric_head}, value={v}, description='{metric_description}'"

)

else:

logger.debug(f"Not dictionary: header={header}, data_dict={data_dict}")

Esse é um método recursivo. Olhando pra uma estrutura como essa aqui:

{

"coretemp-isa-0000":{

"Package id 0":{

"temp1_input": 61.000,

"temp1_max": 100.000,

"temp1_crit": 100.000,

"temp1_crit_alarm": 0.000

}

}

}

O loop quebra o dicionário recebido em k, v, ou "key" e "value".

Na primeira vez que recebe, os dados ficam assim:

{"Package id 0":{"temp1_input": 61.000,"temp1_max": 100.000,"temp1_crit": 100.000,"temp1_crit_alarm": 0.000 }}

Então ele se chama de novo, mas passa no parâmetro header a primeira chave que encontrou: coretemp-isa-0000.

{"temp1_input": 61.000,"temp1_max": 100.000,"temp1_max": 100.000,"temp1_crit_alarm": 0.000 }

Como value ainda é um dictionário, testando com isinstance( ), então ele

adiciona a chave Package id 0 na lista de headers e roda mais uma vez:

Como é um for-loop, ele pega essas chaves e valores.

Daí como tem o histórico do que veio antes dentro de header, fica fácil montar a estrutura.

Basta juntar tudo com "_" como separador.

def generateMetricHeader(self, header: list, key: str) -> str:

metric_header = "_".join(header)

metric_header = re.sub(" ", "_", metric_header)

return f"{metric_header}_{key}"

E é isso que é feito no método generateMetricHeader( ).

Espero que agora tenha ficado um pouco mais claro o que foi que eu fiz nesse programa. E o porquê de não saber se o valor é temperatura em Celsius ou o que seja, uma vez que esse dado não existe na estrutura em JSON gerada. Ou se é tensão em Volts. Fica tudo no mesmo balaio.

Nota: a manpage do sensors descreve que toda temperatura é por padrão em °C pra temperatura.

E também descreve que eu deveria estar usando o parâmetro "-J", que sai no formato que preciso.

Isso fica pra versão 0.2.0 do script 😊.

Rodando simplemente pelo shell, temos a seguinte saída (que pode mudar de acordo com seu hardware):

❯ sensors

coretemp-isa-0000

Adapter: ISA adapter

Package id 0: +61.0°C (high = +100.0°C, crit = +100.0°C)

Core 0: +53.0°C (high = +100.0°C, crit = +100.0°C)

Core 4: +57.0°C (high = +100.0°C, crit = +100.0°C)

Core 8: +61.0°C (high = +100.0°C, crit = +100.0°C)

Core 9: +61.0°C (high = +100.0°C, crit = +100.0°C)

Core 10: +61.0°C (high = +100.0°C, crit = +100.0°C)

Core 11: +61.0°C (high = +100.0°C, crit = +100.0°C)

Core 12: +60.0°C (high = +100.0°C, crit = +100.0°C)

Core 13: +60.0°C (high = +100.0°C, crit = +100.0°C)

Core 14: +60.0°C (high = +100.0°C, crit = +100.0°C)

Core 15: +60.0°C (high = +100.0°C, crit = +100.0°C)

thinkpad-isa-0000

Adapter: ISA adapter

fan1: 2199 RPM

CPU: +60.0°C

GPU: N/A

temp3: +60.0°C

temp4: +0.0°C

temp5: +60.0°C

temp6: +60.0°C

temp7: +60.0°C

temp8: N/A

ucsi_source_psy_USBC000:001-isa-0000

Adapter: ISA adapter

in0: 0.00 V (min = +0.00 V, max = +0.00 V)

curr1: 0.00 A (max = +0.00 A)

BAT0-acpi-0

Adapter: ACPI interface

in0: 12.91 V

power1: 0.00 W

iwlwifi_1-virtual-0

Adapter: Virtual device

temp1: +43.0°C

ucsi_source_psy_USBC000:002-isa-0000

Adapter: ISA adapter

in0: 0.00 V (min = +0.00 V, max = +0.00 V)

curr1: 3.00 A (max = +0.00 A)

nvme-pci-0200

Adapter: PCI adapter

Composite: +45.9°C (low = -273.1°C, high = +85.8°C)

(crit = +86.8°C)

Sensor 1: +48.9°C (low = -273.1°C, high = +65261.8°C)

Sensor 2: +45.9°C (low = -273.1°C, high = +65261.8°C)

acpitz-acpi-0

Adapter: ACPI interface

temp1: +60.0°C

❯ ./sensors-open-metrics.py --printout

#HELP coretemp-isa-0000_Package_id_0_temp1_input coretemp-isa-0000 Package id 0 temp1_input

#TYPE coretemp-isa-0000_Package_id_0_temp1_input gauge

coretemp-isa-0000_Package_id_0_temp1_input: 66.0

#HELP coretemp-isa-0000_Package_id_0_temp1_max coretemp-isa-0000 Package id 0 temp1_max

#TYPE coretemp-isa-0000_Package_id_0_temp1_max gauge

coretemp-isa-0000_Package_id_0_temp1_max: 100.0

#HELP coretemp-isa-0000_Package_id_0_temp1_crit coretemp-isa-0000 Package id 0 temp1_crit

#TYPE coretemp-isa-0000_Package_id_0_temp1_crit gauge

coretemp-isa-0000_Package_id_0_temp1_crit: 100.0

#HELP coretemp-isa-0000_Package_id_0_temp1_crit_alarm coretemp-isa-0000 Package id 0 temp1_crit_alarm

#TYPE coretemp-isa-0000_Package_id_0_temp1_crit_alarm gauge

coretemp-isa-0000_Package_id_0_temp1_crit_alarm: 0.0

#HELP coretemp-isa-0000_Core_0_temp2_input coretemp-isa-0000 Core 0 temp2_input

#TYPE coretemp-isa-0000_Core_0_temp2_input gauge

coretemp-isa-0000_Core_0_temp2_input: 61.0

#HELP coretemp-isa-0000_Core_0_temp2_max coretemp-isa-0000 Core 0 temp2_max

#TYPE coretemp-isa-0000_Core_0_temp2_max gauge

coretemp-isa-0000_Core_0_temp2_max: 100.0

#HELP coretemp-isa-0000_Core_0_temp2_crit coretemp-isa-0000 Core 0 temp2_crit

#TYPE coretemp-isa-0000_Core_0_temp2_crit gauge

coretemp-isa-0000_Core_0_temp2_crit: 100.0

#HELP coretemp-isa-0000_Core_0_temp2_crit_alarm coretemp-isa-0000 Core 0 temp2_crit_alarm

#TYPE coretemp-isa-0000_Core_0_temp2_crit_alarm gauge

coretemp-isa-0000_Core_0_temp2_crit_alarm: 0.0

#HELP coretemp-isa-0000_Core_4_temp6_input coretemp-isa-0000 Core 4 temp6_input

#TYPE coretemp-isa-0000_Core_4_temp6_input gauge

coretemp-isa-0000_Core_4_temp6_input: 58.0

#HELP coretemp-isa-0000_Core_4_temp6_max coretemp-isa-0000 Core 4 temp6_max

#TYPE coretemp-isa-0000_Core_4_temp6_max gauge

coretemp-isa-0000_Core_4_temp6_max: 100.0

#HELP coretemp-isa-0000_Core_4_temp6_crit coretemp-isa-0000 Core 4 temp6_crit

#TYPE coretemp-isa-0000_Core_4_temp6_crit gauge

coretemp-isa-0000_Core_4_temp6_crit: 100.0

#HELP coretemp-isa-0000_Core_4_temp6_crit_alarm coretemp-isa-0000 Core 4 temp6_crit_alarm

#TYPE coretemp-isa-0000_Core_4_temp6_crit_alarm gauge

coretemp-isa-0000_Core_4_temp6_crit_alarm: 0.0

#HELP coretemp-isa-0000_Core_8_temp10_input coretemp-isa-0000 Core 8 temp10_input

#TYPE coretemp-isa-0000_Core_8_temp10_input gauge

coretemp-isa-0000_Core_8_temp10_input: 66.0

#HELP coretemp-isa-0000_Core_8_temp10_max coretemp-isa-0000 Core 8 temp10_max

#TYPE coretemp-isa-0000_Core_8_temp10_max gauge

coretemp-isa-0000_Core_8_temp10_max: 100.0

#HELP coretemp-isa-0000_Core_8_temp10_crit coretemp-isa-0000 Core 8 temp10_crit

#TYPE coretemp-isa-0000_Core_8_temp10_crit gauge

coretemp-isa-0000_Core_8_temp10_crit: 100.0

#HELP coretemp-isa-0000_Core_8_temp10_crit_alarm coretemp-isa-0000 Core 8 temp10_crit_alarm

#TYPE coretemp-isa-0000_Core_8_temp10_crit_alarm gauge

coretemp-isa-0000_Core_8_temp10_crit_alarm: 0.0

#HELP coretemp-isa-0000_Core_9_temp11_input coretemp-isa-0000 Core 9 temp11_input

#TYPE coretemp-isa-0000_Core_9_temp11_input gauge

coretemp-isa-0000_Core_9_temp11_input: 66.0

#HELP coretemp-isa-0000_Core_9_temp11_max coretemp-isa-0000 Core 9 temp11_max

#TYPE coretemp-isa-0000_Core_9_temp11_max gauge

coretemp-isa-0000_Core_9_temp11_max: 100.0

#HELP coretemp-isa-0000_Core_9_temp11_crit coretemp-isa-0000 Core 9 temp11_crit

#TYPE coretemp-isa-0000_Core_9_temp11_crit gauge

coretemp-isa-0000_Core_9_temp11_crit: 100.0

#HELP coretemp-isa-0000_Core_9_temp11_crit_alarm coretemp-isa-0000 Core 9 temp11_crit_alarm

#TYPE coretemp-isa-0000_Core_9_temp11_crit_alarm gauge

coretemp-isa-0000_Core_9_temp11_crit_alarm: 0.0

#HELP coretemp-isa-0000_Core_10_temp12_input coretemp-isa-0000 Core 10 temp12_input

#TYPE coretemp-isa-0000_Core_10_temp12_input gauge

coretemp-isa-0000_Core_10_temp12_input: 66.0

#HELP coretemp-isa-0000_Core_10_temp12_max coretemp-isa-0000 Core 10 temp12_max

#TYPE coretemp-isa-0000_Core_10_temp12_max gauge

coretemp-isa-0000_Core_10_temp12_max: 100.0

#HELP coretemp-isa-0000_Core_10_temp12_crit coretemp-isa-0000 Core 10 temp12_crit

#TYPE coretemp-isa-0000_Core_10_temp12_crit gauge

coretemp-isa-0000_Core_10_temp12_crit: 100.0

#HELP coretemp-isa-0000_Core_10_temp12_crit_alarm coretemp-isa-0000 Core 10 temp12_crit_alarm

#TYPE coretemp-isa-0000_Core_10_temp12_crit_alarm gauge

coretemp-isa-0000_Core_10_temp12_crit_alarm: 0.0

#HELP coretemp-isa-0000_Core_11_temp13_input coretemp-isa-0000 Core 11 temp13_input

#TYPE coretemp-isa-0000_Core_11_temp13_input gauge

coretemp-isa-0000_Core_11_temp13_input: 66.0

#HELP coretemp-isa-0000_Core_11_temp13_max coretemp-isa-0000 Core 11 temp13_max

#TYPE coretemp-isa-0000_Core_11_temp13_max gauge

coretemp-isa-0000_Core_11_temp13_max: 100.0

#HELP coretemp-isa-0000_Core_11_temp13_crit coretemp-isa-0000 Core 11 temp13_crit

#TYPE coretemp-isa-0000_Core_11_temp13_crit gauge

coretemp-isa-0000_Core_11_temp13_crit: 100.0

#HELP coretemp-isa-0000_Core_11_temp13_crit_alarm coretemp-isa-0000 Core 11 temp13_crit_alarm

#TYPE coretemp-isa-0000_Core_11_temp13_crit_alarm gauge

coretemp-isa-0000_Core_11_temp13_crit_alarm: 0.0

#HELP coretemp-isa-0000_Core_12_temp14_input coretemp-isa-0000 Core 12 temp14_input

#TYPE coretemp-isa-0000_Core_12_temp14_input gauge

coretemp-isa-0000_Core_12_temp14_input: 61.0

#HELP coretemp-isa-0000_Core_12_temp14_max coretemp-isa-0000 Core 12 temp14_max

#TYPE coretemp-isa-0000_Core_12_temp14_max gauge

coretemp-isa-0000_Core_12_temp14_max: 100.0

#HELP coretemp-isa-0000_Core_12_temp14_crit coretemp-isa-0000 Core 12 temp14_crit

#TYPE coretemp-isa-0000_Core_12_temp14_crit gauge

coretemp-isa-0000_Core_12_temp14_crit: 100.0

#HELP coretemp-isa-0000_Core_12_temp14_crit_alarm coretemp-isa-0000 Core 12 temp14_crit_alarm

#TYPE coretemp-isa-0000_Core_12_temp14_crit_alarm gauge

coretemp-isa-0000_Core_12_temp14_crit_alarm: 0.0

#HELP coretemp-isa-0000_Core_13_temp15_input coretemp-isa-0000 Core 13 temp15_input

#TYPE coretemp-isa-0000_Core_13_temp15_input gauge

coretemp-isa-0000_Core_13_temp15_input: 61.0

#HELP coretemp-isa-0000_Core_13_temp15_max coretemp-isa-0000 Core 13 temp15_max

#TYPE coretemp-isa-0000_Core_13_temp15_max gauge

coretemp-isa-0000_Core_13_temp15_max: 100.0

#HELP coretemp-isa-0000_Core_13_temp15_crit coretemp-isa-0000 Core 13 temp15_crit

#TYPE coretemp-isa-0000_Core_13_temp15_crit gauge

coretemp-isa-0000_Core_13_temp15_crit: 100.0

#HELP coretemp-isa-0000_Core_13_temp15_crit_alarm coretemp-isa-0000 Core 13 temp15_crit_alarm

#TYPE coretemp-isa-0000_Core_13_temp15_crit_alarm gauge

coretemp-isa-0000_Core_13_temp15_crit_alarm: 0.0

#HELP coretemp-isa-0000_Core_14_temp16_input coretemp-isa-0000 Core 14 temp16_input

#TYPE coretemp-isa-0000_Core_14_temp16_input gauge

coretemp-isa-0000_Core_14_temp16_input: 61.0

#HELP coretemp-isa-0000_Core_14_temp16_max coretemp-isa-0000 Core 14 temp16_max

#TYPE coretemp-isa-0000_Core_14_temp16_max gauge

coretemp-isa-0000_Core_14_temp16_max: 100.0

#HELP coretemp-isa-0000_Core_14_temp16_crit coretemp-isa-0000 Core 14 temp16_crit

#TYPE coretemp-isa-0000_Core_14_temp16_crit gauge

coretemp-isa-0000_Core_14_temp16_crit: 100.0

#HELP coretemp-isa-0000_Core_14_temp16_crit_alarm coretemp-isa-0000 Core 14 temp16_crit_alarm

#TYPE coretemp-isa-0000_Core_14_temp16_crit_alarm gauge

coretemp-isa-0000_Core_14_temp16_crit_alarm: 0.0

#HELP coretemp-isa-0000_Core_15_temp17_input coretemp-isa-0000 Core 15 temp17_input

#TYPE coretemp-isa-0000_Core_15_temp17_input gauge

coretemp-isa-0000_Core_15_temp17_input: 61.0

#HELP coretemp-isa-0000_Core_15_temp17_max coretemp-isa-0000 Core 15 temp17_max

#TYPE coretemp-isa-0000_Core_15_temp17_max gauge

coretemp-isa-0000_Core_15_temp17_max: 100.0

#HELP coretemp-isa-0000_Core_15_temp17_crit coretemp-isa-0000 Core 15 temp17_crit

#TYPE coretemp-isa-0000_Core_15_temp17_crit gauge

coretemp-isa-0000_Core_15_temp17_crit: 100.0

#HELP coretemp-isa-0000_Core_15_temp17_crit_alarm coretemp-isa-0000 Core 15 temp17_crit_alarm

#TYPE coretemp-isa-0000_Core_15_temp17_crit_alarm gauge

coretemp-isa-0000_Core_15_temp17_crit_alarm: 0.0

#HELP thinkpad-isa-0000_fan1_fan1_input thinkpad-isa-0000 fan1 fan1_input

#TYPE thinkpad-isa-0000_fan1_fan1_input gauge

thinkpad-isa-0000_fan1_fan1_input: 2191.0

#HELP thinkpad-isa-0000_CPU_temp1_input thinkpad-isa-0000 CPU temp1_input

#TYPE thinkpad-isa-0000_CPU_temp1_input gauge

thinkpad-isa-0000_CPU_temp1_input: 60.0

#HELP thinkpad-isa-0000_temp3_temp3_input thinkpad-isa-0000 temp3 temp3_input

#TYPE thinkpad-isa-0000_temp3_temp3_input gauge

thinkpad-isa-0000_temp3_temp3_input: 60.0

#HELP thinkpad-isa-0000_temp4_temp4_input thinkpad-isa-0000 temp4 temp4_input

#TYPE thinkpad-isa-0000_temp4_temp4_input gauge

thinkpad-isa-0000_temp4_temp4_input: 0.0

#HELP thinkpad-isa-0000_temp5_temp5_input thinkpad-isa-0000 temp5 temp5_input

#TYPE thinkpad-isa-0000_temp5_temp5_input gauge

thinkpad-isa-0000_temp5_temp5_input: 60.0

#HELP thinkpad-isa-0000_temp6_temp6_input thinkpad-isa-0000 temp6 temp6_input

#TYPE thinkpad-isa-0000_temp6_temp6_input gauge

thinkpad-isa-0000_temp6_temp6_input: 60.0

#HELP thinkpad-isa-0000_temp7_temp7_input thinkpad-isa-0000 temp7 temp7_input

#TYPE thinkpad-isa-0000_temp7_temp7_input gauge

thinkpad-isa-0000_temp7_temp7_input: 60.0

#HELP ucsi_source_psy_USBC000:001-isa-0000_in0_in0_input ucsi_source_psy_USBC000:001-isa-0000 in0 in0_input

#TYPE ucsi_source_psy_USBC000:001-isa-0000_in0_in0_input gauge

ucsi_source_psy_USBC000:001-isa-0000_in0_in0_input: 0.0

#HELP ucsi_source_psy_USBC000:001-isa-0000_in0_in0_min ucsi_source_psy_USBC000:001-isa-0000 in0 in0_min

#TYPE ucsi_source_psy_USBC000:001-isa-0000_in0_in0_min gauge

ucsi_source_psy_USBC000:001-isa-0000_in0_in0_min: 0.0

#HELP ucsi_source_psy_USBC000:001-isa-0000_in0_in0_max ucsi_source_psy_USBC000:001-isa-0000 in0 in0_max

#TYPE ucsi_source_psy_USBC000:001-isa-0000_in0_in0_max gauge

ucsi_source_psy_USBC000:001-isa-0000_in0_in0_max: 0.0

#HELP ucsi_source_psy_USBC000:001-isa-0000_curr1_curr1_input ucsi_source_psy_USBC000:001-isa-0000 curr1 curr1_input

#TYPE ucsi_source_psy_USBC000:001-isa-0000_curr1_curr1_input gauge

ucsi_source_psy_USBC000:001-isa-0000_curr1_curr1_input: 0.0

#HELP ucsi_source_psy_USBC000:001-isa-0000_curr1_curr1_max ucsi_source_psy_USBC000:001-isa-0000 curr1 curr1_max

#TYPE ucsi_source_psy_USBC000:001-isa-0000_curr1_curr1_max gauge

ucsi_source_psy_USBC000:001-isa-0000_curr1_curr1_max: 0.0

#HELP BAT0-acpi-0_in0_in0_input BAT0-acpi-0 in0 in0_input

#TYPE BAT0-acpi-0_in0_in0_input gauge

BAT0-acpi-0_in0_in0_input: 12.909

#HELP BAT0-acpi-0_power1_power1_input BAT0-acpi-0 power1 power1_input

#TYPE BAT0-acpi-0_power1_power1_input gauge

BAT0-acpi-0_power1_power1_input: 0.0

#HELP iwlwifi_1-virtual-0_temp1_temp1_input iwlwifi_1-virtual-0 temp1 temp1_input

#TYPE iwlwifi_1-virtual-0_temp1_temp1_input gauge

iwlwifi_1-virtual-0_temp1_temp1_input: 43.0

#HELP ucsi_source_psy_USBC000:002-isa-0000_in0_in0_input ucsi_source_psy_USBC000:002-isa-0000 in0 in0_input

#TYPE ucsi_source_psy_USBC000:002-isa-0000_in0_in0_input gauge

ucsi_source_psy_USBC000:002-isa-0000_in0_in0_input: 0.0

#HELP ucsi_source_psy_USBC000:002-isa-0000_in0_in0_min ucsi_source_psy_USBC000:002-isa-0000 in0 in0_min

#TYPE ucsi_source_psy_USBC000:002-isa-0000_in0_in0_min gauge

ucsi_source_psy_USBC000:002-isa-0000_in0_in0_min: 0.0

#HELP ucsi_source_psy_USBC000:002-isa-0000_in0_in0_max ucsi_source_psy_USBC000:002-isa-0000 in0 in0_max

#TYPE ucsi_source_psy_USBC000:002-isa-0000_in0_in0_max gauge

ucsi_source_psy_USBC000:002-isa-0000_in0_in0_max: 0.0

#HELP ucsi_source_psy_USBC000:002-isa-0000_curr1_curr1_input ucsi_source_psy_USBC000:002-isa-0000 curr1 curr1_input

#TYPE ucsi_source_psy_USBC000:002-isa-0000_curr1_curr1_input gauge

ucsi_source_psy_USBC000:002-isa-0000_curr1_curr1_input: 3.0

#HELP ucsi_source_psy_USBC000:002-isa-0000_curr1_curr1_max ucsi_source_psy_USBC000:002-isa-0000 curr1 curr1_max

#TYPE ucsi_source_psy_USBC000:002-isa-0000_curr1_curr1_max gauge

ucsi_source_psy_USBC000:002-isa-0000_curr1_curr1_max: 0.0

#HELP nvme-pci-0200_Composite_temp1_input nvme-pci-0200 Composite temp1_input

#TYPE nvme-pci-0200_Composite_temp1_input gauge

nvme-pci-0200_Composite_temp1_input: 45.85

#HELP nvme-pci-0200_Composite_temp1_max nvme-pci-0200 Composite temp1_max

#TYPE nvme-pci-0200_Composite_temp1_max gauge

nvme-pci-0200_Composite_temp1_max: 85.85

#HELP nvme-pci-0200_Composite_temp1_min nvme-pci-0200 Composite temp1_min

#TYPE nvme-pci-0200_Composite_temp1_min gauge

nvme-pci-0200_Composite_temp1_min: -273.15

#HELP nvme-pci-0200_Composite_temp1_crit nvme-pci-0200 Composite temp1_crit

#TYPE nvme-pci-0200_Composite_temp1_crit gauge

nvme-pci-0200_Composite_temp1_crit: 86.85

#HELP nvme-pci-0200_Composite_temp1_alarm nvme-pci-0200 Composite temp1_alarm

#TYPE nvme-pci-0200_Composite_temp1_alarm gauge

nvme-pci-0200_Composite_temp1_alarm: 0.0

#HELP nvme-pci-0200_Sensor_1_temp2_input nvme-pci-0200 Sensor 1 temp2_input

#TYPE nvme-pci-0200_Sensor_1_temp2_input gauge

nvme-pci-0200_Sensor_1_temp2_input: 50.85

#HELP nvme-pci-0200_Sensor_1_temp2_max nvme-pci-0200 Sensor 1 temp2_max

#TYPE nvme-pci-0200_Sensor_1_temp2_max gauge

nvme-pci-0200_Sensor_1_temp2_max: 65261.85

#HELP nvme-pci-0200_Sensor_1_temp2_min nvme-pci-0200 Sensor 1 temp2_min

#TYPE nvme-pci-0200_Sensor_1_temp2_min gauge

nvme-pci-0200_Sensor_1_temp2_min: -273.15

#HELP nvme-pci-0200_Sensor_2_temp3_input nvme-pci-0200 Sensor 2 temp3_input

#TYPE nvme-pci-0200_Sensor_2_temp3_input gauge

nvme-pci-0200_Sensor_2_temp3_input: 45.85

#HELP nvme-pci-0200_Sensor_2_temp3_max nvme-pci-0200 Sensor 2 temp3_max

#TYPE nvme-pci-0200_Sensor_2_temp3_max gauge

nvme-pci-0200_Sensor_2_temp3_max: 65261.85

#HELP nvme-pci-0200_Sensor_2_temp3_min nvme-pci-0200 Sensor 2 temp3_min

#TYPE nvme-pci-0200_Sensor_2_temp3_min gauge

nvme-pci-0200_Sensor_2_temp3_min: -273.15

#HELP acpitz-acpi-0_temp1_temp1_input acpitz-acpi-0 temp1 temp1_input

#TYPE acpitz-acpi-0_temp1_temp1_input gauge

acpitz-acpi-0_temp1_temp1_input: 60.0

Os dados aparecem no #HELP simplesmente sem os _.

Talvez eu devesse melhorar e fazer com que alguns valores fosse labels do valor maior.

Mas por enquanto está funcionando assim.

E pra rodar como serviço:

❯ ./sensors-open-metrics.py

[2025-12-12 19:54:43] (INFO) starting service on port 9090

INFO: Started server process [1078630]

INFO: Waiting for application startup.

INFO: Application startup complete.

INFO: Uvicorn running on http://127.0.0.1:9090 (Press CTRL+C to quit)

[2025-12-12 19:54:53] (INFO) serving web page on /metrics

INFO: 127.0.0.1:52250 - "GET /metrics HTTP/1.1" 200 OK

Em outro terminal:

❯ curl localhost:9090/metrics

#HELP coretemp-isa-0000_Package_id_0_temp1_input coretemp-isa-0000 Package id 0 temp1_input

#TYPE coretemp-isa-0000_Package_id_0_temp1_input gauge

coretemp-isa-0000_Package_id_0_temp1_input: 62.0

#HELP coretemp-isa-0000_Package_id_0_temp1_max coretemp-isa-0000 Package id 0 temp1_max

#TYPE coretemp-isa-0000_Package_id_0_temp1_max gauge

coretemp-isa-0000_Package_id_0_temp1_max: 100.0

#HELP coretemp-isa-0000_Package_id_0_temp1_crit coretemp-isa-0000 Package id 0 temp1_crit

#TYPE coretemp-isa-0000_Package_id_0_temp1_crit gauge

coretemp-isa-0000_Package_id_0_temp1_crit: 100.0

#HELP coretemp-isa-0000_Package_id_0_temp1_crit_alarm coretemp-isa-0000 Package id 0 temp1_crit_alarm

[...]

Pra rodar como serviço do systemd em /etc/systemd/system/sensors-open-metrics.service:

[Unit]

Description=Temperature sensors

Wants=network-online.target

After=network-online.target nginx.service

[Service]

Restart=always

User=root

Group=root

WorkingDirectory=/tmp

ExecStart=/usr/local/bin/sensors-open-metrics.py

TimeoutStopSec=5s

[Install]

WantedBy=multi-user.target

E finalmente adicionando em /etc/alloy/config.alloy:

[...]

discovery.relabel "temperature_metrics" {

targets = array.concat(

[{

__address__ = "localhost:9090",

}],

)

rule {

source_labels = ["__address__"]

target_label = "instance"

replacement = "nome_do_servidor"

}

}

prometheus.scrape "temperature_metrics" {

targets = discovery.relabel.temperature_metrics.output

forward_to = [prometheus.remote_write.prod.receiver]

job_name = "temperature"

}

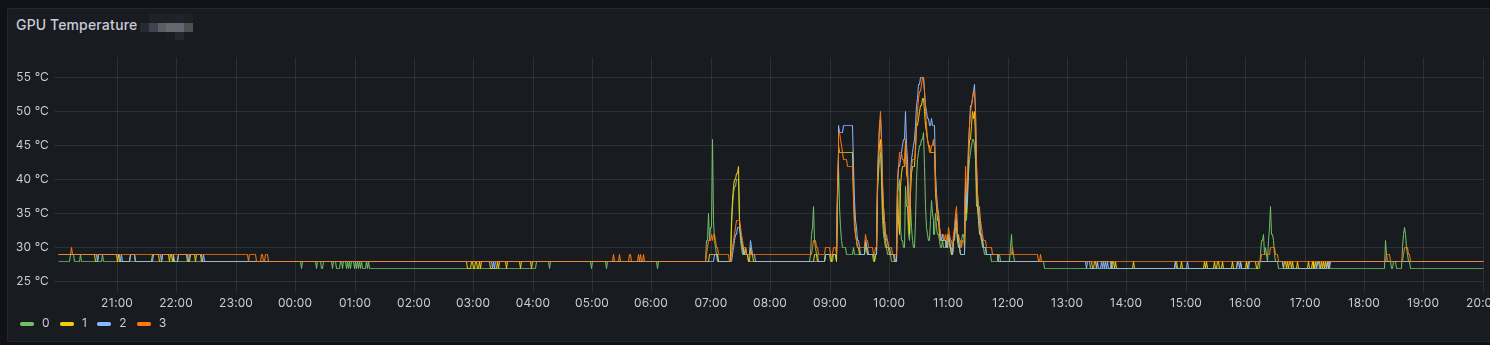

Daí é só evocar o Grafana e partir por gráficos.

Update: atualizado em

Sat Dec 13 02:43:59 PM CET 2025

com mais informação sobre a parte de script.

Essa semana recebi uma missão: permitir acesso aos logs de um container numa VM em que a pessoa não pode conectar.

Pense em algumas opções e a que me pareceu mais apropriada foi criar um pequeno serviço com python, fastapi e uvicorn. E deixar disponível como acesso http.

Então fiz um programa bem simples:

#! /usr/bin/env python3

import uvicorn

from fastapi import FastAPI

from fastapi.responses import PlainTextResponse, StreamingResponse

import subprocess

# https://stackoverflow.com/questions/4417546/constantly-print-subprocess-output-while-process-is-running

def shellExec(command: list[str]):

popen = subprocess.Popen(command, stdout=subprocess.PIPE, universal_newlines=True)

for stdout_line in iter(popen.stdout.readline, ""):

yield stdout_line

popen.stdout.close()

return_code = popen.wait()

if return_code:

raise subprocess.CalledProcessError(return_code, command)

def getContainerLogs():

for line in shellExec(["docker", "logs", "ubuntu", "-f"]):

yield line

app = FastAPI()

@app.get("/logs", response_class=PlainTextResponse)

async def getLogs():

return StreamingResponse(getContainerLogs(), media_type="text/plain")

if __name__ == '__main__':

uvicorn.run(app, host="0.0.0.0", port=8080)

O programa então roda o comando docker logs ubuntu -f pra ficar lendo os logs vindo do container "ubuntu".

Nada muito fantástico.

E como deixar rodando?

Eu podia criar um container que pudesse acessar /var/run/docker.socket pra ler info dos containers rodando.

E os logs.

Mas fui pela simplicidade e só criei um serviço do systemd mesmo.

[Unit]

Description=Stream logs from ubuntu container

Wants=network-online.target

After=network-online.target docker.service

[Service]

User=helio

Group=hackerz

Restart=always

WorkingDirectory=/home/helio/bin

ExecStart=/home/helio/bin/stream-logs-container.py

# If running the Agent in scraping service mode, you will want to override this value with

# something larger to allow the Agent to gracefully leave the cluster. 4800s is recommend.

TimeoutStopSec=5s

[Install]

WantedBy=multi-user.target

Daí bastou ativar e partir pro abraço.

❯ sudo systemctl enable --now stream-logs-container.service

Password:

❯ curl localhost:8080/logs

mariadb 12:38:12.20 INFO ==>

mariadb 12:38:12.21 INFO ==> Welcome to the Bitnami mariadb container

mariadb 12:38:12.21 INFO ==> Subscribe to project updates by watching https://github.com/bitnami/containers

mariadb 12:38:12.21 INFO ==> Did you know there are enterprise versions of the Bitnami catalog? For enhanced secure software supply chain features, unlimited pulls from Docker, LTS support, or application customization, see Bitnami Premium or Tanzu Application Catalog. See https://www.arrow.com/globalecs/na/vendors/bitnami/ for more information.

mariadb 12:38:12.22 INFO ==>

mariadb 12:38:12.22 INFO ==> ** Starting MariaDB setup **

mariadb 12:38:12.25 INFO ==> Validating settings in MYSQL_*/MARIADB_* env vars

mariadb 12:38:12.26 INFO ==> Initializing mariadb database

mariadb 12:38:12.28 INFO ==> Updating 'my.cnf' with custom configuration

mariadb 12:38:12.29 INFO ==> Setting slow_query_log option

mariadb 12:38:12.35 INFO ==> Setting long_query_time option

mariadb 12:38:12.37 INFO ==> Installing database

mariadb 12:38:13.91 INFO ==> Starting mariadb in background

2025-10-02 12:38:13 0 [Note] Starting MariaDB 10.11.11-MariaDB source revision e69f8cae1a15e15b9e4f5e0f8497e1f17bdc81a4 server_uid RV0GswTTbCaNJgiFfL+XFbloFPM= as process 98

2025-10-02 12:38:13 0 [Note] InnoDB: Compressed tables use zlib 1.2.13

2025-10-02 12:38:13 0 [Note] InnoDB: Number of transaction pools: 1

2025-10-02 12:38:13 0 [Note] InnoDB: Using crc32 + pclmulqdq instructions

2025-10-02 12:38:14 0 [Note] InnoDB: Using Linux native AIO

2025-10-02 12:38:14 0 [Note] InnoDB: Initializing buffer pool, total size = 128.000MiB, chunk size = 2.000MiB

2025-10-02 12:38:14 0 [Note] InnoDB: Completed initialization of buffer pool

2025-10-02 12:38:14 0 [Note] InnoDB: Buffered log writes (block size=512 bytes)

2025-10-02 12:38:14 0 [Note] InnoDB: End of log at LSN=45502

2025-10-02 12:38:14 0 [Note] InnoDB: 128 rollback segments are active.

2025-10-02 12:38:14 0 [Note] InnoDB: Setting file './ibtmp1' size to 12.000MiB. Physically writing the file full; Please wait ...

2025-10-02 12:38:14 0 [Note] InnoDB: File './ibtmp1' size is now 12.000MiB.

^C

Como ele fica lendo sem parar os logs, é preciso um "ctrl+c" pra sair.

Eu tenho rodado um tipo de sistema que faz DynDNS pra minhas máquinas que estão atrás de um serviço de DHCP como meu desktop que fica aqui em minha mesa, em casa.

O princípio é que essa máquina acessa uma certa URL a cada 5 minutos. Então a cada 5 minutos eu olho pro log do servidor web que roda nessa porta e pego os dados. Pego o IPv4 e o IPv6. Na verdade pego o que vier e vejo se é IPv4 ou IPv6. Depois olho no mapa de DNS se o valor mudou. Se mudou, altero o serial do map e mando um restart no serviço.

A lógica é simples. Mas eu fiz isso uns 15 anos atrás. Pra python2.Alguma-Coisa. Portei pra python3 no melhor estilo #XGH. O resultado? Problemas aqui e ali.

Vamos dar uma olhada no script anterior.

#! /usr/bin/python3 -u

# -*- encoding: utf-8 -*-

"""

DNS updater. It checks if hostname and IP are updated

on maps. If not, update accordingly and reload bind.

"""

# grep "\/\?update_dyndns=" /var/log/apache2/dyndns-access.log | sed "s/ HTTP.*//" | awk '{print $1, $NF}'

import re

import time

import os

import subprocess

import sys

LOG = "/var/log/apache2/dyndns-access.log"

DNSCONF = "/etc/bind/master/dyndns.truta.org"

DNSDATE = "/etc/bind/master/db.truta.org"

DNSFILES = [ DNSDATE, "/etc/bind/master/db.linux-br.org" ]

TRANSLATE = {

"goosfraba" : "helio",

"raspberrypi-masoso" : "rpi0",

"raspberrypi1" : "rpi1",

"raspberrypi2" : "rpi2",

"raspberrypi3" : "rpi3"

}

def debug(*msg):

if "DEBUG" in os.environ:

print("DEBUG:", *msg)

def get_latest_ips():

"""

Dictionary in format:

Domain/node : [ ipv4, ipv6]

"""

debug("get_latest_ips()")

NODE_IP = {}

with open(LOG) as logfile:

for line in logfile.readlines():

if not re.search("\/\?update_dyndns=", line):

continue

line = re.sub(" HTTP.*", "", line)

param = line.split()

ip = param[0]

nodename = re.sub("\/\?update_dyndns=", "", param[-1])

if not nodename in NODE_IP:

NODE_IP[nodename] = [ None, None ]

# ipv4?

if re.search("([0-9].*)\.([0-9].*)\.([0-9].*)\.([0-9].*)", ip):

NODE_IP[nodename][0] = ip

debug(f"{nodename} (ipv4): {ip}")

else:

NODE_IP[nodename][1] = ip

debug(f"{nodename} (ipv6): {ip}")

return NODE_IP

def apply_translate(DIC):

debug("apply_translate()")

# DIC = { translatedName : [ipv4, ipv6] }

debug("apply_translate(): DIC:\n", DIC)

tempDIC = {}

for nodename in DIC:

debug(f"apply_translate(): searching {nodename}")

if not nodename in TRANSLATE:

debug(f"{nodename} not in TRANSLATE table")

continue

dnsName = TRANSLATE[nodename]

if dnsName is None:

debug(f"{nodename} translates to None")

continue

nodeValue = DIC[nodename]

debug(f"apply_translate(): adding {dnsName} as {nodeValue}")

tempDIC[dnsName] = nodeValue

debug("apply_translate(): returning tempDIC:\n", tempDIC)

return tempDIC

def check_for_update(DIC):

debug("check_for_update()")

isupdated = False

buf = ""

debug("check_for_update(): current DNS entries")

with open(DNSCONF) as fh:

for line in fh.readlines():

if line.startswith(";") or line.startswith("#"):

buf += line

continue

line = line.rstrip()

param = line.split()

if len(param) != 3:

buf += f"{line}\n"

continue

subname, subtype, subip = param

print(f"DNS current entry: {subname}, Type: {subtype}, IP: {subip}")

if not subname in DIC:

debug(f"check_for_update(): {subname} is not into the DIC")

buf += f"{line}\n"

continue

ipv4, ipv6 = DIC[subname]

print(f"Found {subname} for update")

# ipv4

if subtype == "A":

print("Checking IPv4")

if ipv4 != subip and len(ipv4) > 0:

print(f" * Updating {subname} from {subip} to {ipv4}")

isupdated = True

buf += f"{subname}\t\t\t{subtype}\t{ipv4}\n"

continue

# ipv6

if subtype == "AAAA":

print("Checking IPv6")

if ipv6 != subip and len(ipv6) > 0:

print(f" * Updating {subname} from {subip} to {ipv6}")

isupdated = True

buf += f"{subname}\t\t\t{subtype}\t{ipv6}\n"

continue

buf += f"{line}\n"

if isupdated:

print(f"Updating file {DNSCONF}")

debug("check_for_update(): buf:", buf)

with open(DNSCONF, 'w') as fh:

fh.write(buf)

return isupdated

def get_dns_map_serial(dns_file: str) -> str:

with open(dns_file) as fh:

for line in fh.readlines():

if not re.search(" ; serial", line):

continue

timestamp = line.split()[0]

return timestamp

raise Exception(f"Failed to read serial from dns file: {dns_file}")

def get_serial_date_update(timestamp: str) -> list:

if len(timestamp) != 10 :

raise Exception(f"Wrong timestamp size (not 10): {timestamp}")

dateformat = timestamp[:8]

serial = timestamp[8:]

return (serial)

def update_serial_in_file(old_serial: str, new_serial: str, filename: str) -> None:

with open(filename) as fh:

buf = fh.read()

buf = re.sub(old_serial, new_serial, buf)

with open(filename, 'w') as fw:

fw.write(buf)

def update_timestamp(dryrun=False):

debug("update_timestamp()")

buf = ""

today = time.strftime("%Y%m%d", time.localtime())

timestamp = get_dns_map_serial(DNSDATE)

(last_update, last_serial) = get_serial_date_update(timestamp)

print("Timestamp:", timestamp)

print("Last update:", last_update)

print("Last serial:", last_serial)

original_timestamp = ""

if int(today) > int(last_update):

timestamp = f"{today}00"

else:

serial = int(last_serial) + 1

if serial < 100:

timestamp = "%s%02d" % (today, serial)

else:

timestamp = "%08d00" % (int(today) + 1)

print("New timestamp:", timestamp)

print("Updating file", DNSDATE)

debug(f"update_timestamp(): timestamp={timestamp}")

if dryrun is False:

update_serial_in_file(original_timestamp, timestamp, DNSDATE)

else:

print("-= dry-run mode =-")

print(f"Here file {DNSDATE} would be updated.")

print("Content:\n", buf)

def bind_restart(dryrun=False):

#cmd = "systemctl restart named.service"

## reload is enough

cmd = "systemctl reload named.service"

if dryrun is False:

subprocess.call(cmd.split())

else:

print("-= dry-run mode =-")

print(f"Here command would be called: {cmd}")

def main():

now = time.ctime(time.time())

print(f"Starting: {now}")

DNS = get_latest_ips()

DNS = apply_translate(DNS)

debug(DNS)

status = check_for_update(DNS)

if status:

if len(sys.argv) > 1 and sys.argv[-1] == "--help":

print(f"Use: {sys.argv[0]} [--help|--dry-run]")

sys.exit(0)

if len(sys.argv) > 1 and sys.argv[-1] == "--dry-run":

doDryRun = True

else:

doDryRun = False

update_timestamp(dryrun=doDryRun)

bind_restart(dryrun=doDryRun)

if __name__ == '__main__':

main()

O código está gigante e uma zona. E estava dando crash. Vamos então olhar por partes.

LOG = "/var/log/apache2/dyndns-access.log"

DNSCONF = "/etc/bind/master/dyndns.truta.org"

DNSDATE = ""

DNSFILES = [ DNSDATE, "/etc/bind/master/db.linux-br.org" ]

LOG é onde eu tenho de ler pra buscar o padrão de acesso.

DNSCONF é onde ficam as definições de "IP TIPO NOME" como "1.2.3.4 A helio" pro caso de IPv4.

DNSDATE é onde ficavam as atualizações pro domínio truta.org.

Eu percebi que dava pra fazer a mesma coisa com outros domínios, então depois

eu inseri junto o DNSFILES pra ter também o linux-br.org.

No final esses aquivos só precisam ser abertos pra alterar o serial.

O mapa de dns, pra entender o que é, é esse aqui pro truta.org:

❯ cat /etc/bind/master/db.truta.org

$TTL 180 ; # three minute

@ IN SOA ns1.truta.org. helio.loureiro.eng.br. (

2025080800 ; serial

43200 ; refresh (12 hours)

3600 ; retry (1 hour)

604800 ; expire (1 week)

86400 ; minimum (1 day)

)

@ NS ns1.truta.org.

@ NS ns2.afraid.org.

@ NS ns1.first-ns.de.

@ NS robotns2.second-ns.de.

@ NS robotns3.second-ns.com.

@ A 95.216.213.181

@ MX 5 mail.truta.org.

@ AAAA 2a01:4f9:c012:f3c4::1

@ TXT "v=spf1 a mx ip4:95.216.213.181 ip6:2a01:4f9:c012:f3c4::1 include:_spf.google.com -all"

mail._domainkey IN TXT "v=DKIM1; k=rsa; t=y; p=MIGfMA0GCSqGSIb3DQEBAQUAA4GNADCBiQKBgQCpp/HlB1QAHjp6jHGCj9kfcZSjY3ipbGuU/enVjEeptlNgw2qTxRRJ6puPiW5DWCOaPEg2nC//wRazFgMuLZ3C89vF2TT57upngmNuCcLtbwNxo6G1JFo5GD92UbQgstYC+cjfrRlw56XfwzWVtojR4ZCB8PCQCguwhwunwRhJEwIDAQAB" ; ----- DKIM key mail for truta.org

; As e AAAAs

; CNAMES

www AAAA 2a01:4f9:c012:f3c4::1

www A 95.216.213.181

ns1 A 95.216.213.181

AAAA 2a01:4f9:c012:f3c4::1

mail A 95.216.213.181

AAAA 2a01:4f9:c012:f3c4::1

; DYNAMIC TRUTAS

$INCLUDE "/etc/bind/master/dyndns.truta.org";

A linha que precisa ser alterada é a que tem 2025080800 ; serial.

A parte que faz a mágica de ler os novos endereços IPs é $INCLUDE "/etc/bind/master/dyndns.truta.org";.

E se não está familiarizado com mapas de dns, o que tem depois do ";" é ignorado.

Então o bind lê somente o 2025080800.

O ; serial é um comentário pra humanos entenderem o que é aquilo.

O serial é um número inteiro.

Você pode usar qualquer número.

Só precisa incrementar quando faz alguma alteração no mapa pra poder notificar que houve mudança pro seus secundários.

A boa prática é usar YYYYMMDDXX onde:

Então se o mapa é atualizado no mesmo dia, você incrementa o XX. Claro que isso te limita à 100 alterações por dia, de 0 a 99. Mas não é algo como ficar atualizando tanto o mapa. A menos que você seja um provedor de cloud. Daí as coisas funcionam de jeito beeeeem diferente. Mas vamos ficar no feijão com arroz.

Vamos voltar ao script. Como está escrito com funções, fica mais fácil de olhar pra cada uma independentemente. Eu vou colocar fora de ordem pra ficar mais claro o que faz o quê. Ou o que deveria fazer o quê.

def debug(*msg):

if "DEBUG" in os.environ:

print("DEBUG:", *msg)

Isso é claramente uma gambiarra. XGH em sua melhor forma. Só pra eu ter um "debug" pra olhar dentro do programa.

def main():

now = time.ctime(time.time())

print(f"Starting: {now}")

DNS = get_latest_ips()

DNS = apply_translate(DNS)

debug(DNS)

status = check_for_update(DNS)

if status:

if len(sys.argv) > 1 and sys.argv[-1] == "--help":

print(f"Use: {sys.argv[0]} [--help|--dry-run]")

sys.exit(0)

if len(sys.argv) > 1 and sys.argv[-1] == "--dry-run":

doDryRun = True

else:

doDryRun = False

update_timestamp(dryrun=doDryRun)

bind_restart(dryrun=doDryRun)

if __name__ == '__main__':

main()

A função main é o que chama tudo.

Algumas coisas de tempo pra saber quando começa.

E efetivamente a primeira chamada aqui: DNS = get_latest_ips().

Soa razoável olhar pra esse get_latest_ips() e imaginar que volta os últimos ips.

Mas ip de quem?

Com certeza tem de voltar algo como um dicionário pra você saber qual hostname tem qual ip.

E esse DNS?

Tinha de ser em maiúsculo?

Definitivamente não.

Variáveis em maiúsculo a gente deixa pra constantes como LOG.

Mas seguimos...

Agora temos um DNS = apply_translate(DNS).

Esse é um filtro que usa o TRANSLATE lá em cima:

TRANSLATE = {

"goosfraba" : "helio",

"raspberrypi-masoso" : "rpi0",

"raspberrypi1" : "rpi1",

"raspberrypi2" : "rpi2",

"raspberrypi3" : "rpi3"

}

E isso é usado porque meu desktop, por exemplo, tem hostname "goosfraba". Mas eu quero que ele seja no fqdn como "helio.truta.org". Então eu uso essa "tradução" de hostname recebido pro que eu quero no dns.

status = check_for_update(DNS) eu provavelmente comparo com o que está em DNSCONF.

E se houve alteração, salvo em status.

Definitivamente um boolean.

Em seguinda essa parte aqui:

if status:

if len(sys.argv) > 1 and sys.argv[-1] == "--help":

print(f"Use: {sys.argv[0]} [--help|--dry-run]")

sys.exit(0)

if len(sys.argv) > 1 and sys.argv[-1] == "--dry-run":

doDryRun = True

else:

doDryRun = False

Esse é um outro XGH. Tudo pra ver se existe o parâmetro "--help". Ou se é passado "--dry-run". "dry-run" é como é chamado um "test pra ver se vai" sem realmente fazer nada. Eu provavelmente fiz isso porque a primeira implementação era em shell script. Mas mesmo em shell script isso seria XGH.

update_timestamp(dryrun=doDryRun) faz aquele update de serial nos mapas de dns se algo mudou.

A menos que o parâmetro de "dry-run" esteja lá.

E finalmente bind_restart(dryrun=doDryRun) reinicia o serviço via systemd ser não for um "dry-run".

Olhamos a lógica do que deveria fazer.

Agora vamos ver o que foi feito.

Vamos começar com o get_latest_ips( ).

def get_latest_ips():

"""

Dictionary in format:

Domain/node : [ ipv4, ipv6]

"""

debug("get_latest_ips()")

NODE_IP = {}

with open(LOG) as logfile:

for line in logfile.readlines():

if not re.search("\/\?update_dyndns=", line):

continue

line = re.sub(" HTTP.*", "", line)

param = line.split()

ip = param[0]

nodename = re.sub("\/\?update_dyndns=", "", param[-1])

if not nodename in NODE_IP:

NODE_IP[nodename] = [ None, None ]

# ipv4?

if re.search("([0-9].*)\.([0-9].*)\.([0-9].*)\.([0-9].*)", ip):

NODE_IP[nodename][0] = ip

debug(f"{nodename} (ipv4): {ip}")

else:

NODE_IP[nodename][1] = ip

debug(f"{nodename} (ipv6): {ip}")

return NODE_IP

Aparentemente a estrutura NODE_IP = {} vai ser um dicionário do tipo

hostname: [IPv4][IPv6].

with open(LOG) as logfile:

for line in logfile.readlines():

if not re.search("\/\?update_dyndns=", line):

continue

Aqui é ler o aquivo LOG.

Se a linha não tiver o padrão "/?update_dynds=", vai pra próxima linha.

line = re.sub(" HTTP.*", "", line)

param = line.split()

ip = param[0]

nodename = re.sub("\/\?update_dyndns=", "", param[-1])

A alinha recebida é algo assim:

83.233.219.150 - - [11/Aug/2025:08:54:57 +0000] "GET /?update_dyndns=goosfraba HTTP/1.1" 200 87144 "-" "curl/8.15.0"

Então o regex em line = re.sub(" HTTP.*", "", line) remove tudo depois de " HTTP", including essa parte junto.

A linha então fica algo assim:

83.233.219.150 - - [11/Aug/2025:08:54:57 +0000] "GET /?update_dyndns=goosfraba

A linha param = line.split() cria a variável param (parâmetros) com a linha separada por espaços simples.

ip = param[0] pega o primeiro parâmetro.

No exemplo seria "83.233.219.150".

nodename = re.sub("\/\?update_dyndns=", "", param[-1]) pega o último parâmetro, que no exemplo seria

"/?update_dyndns=goosfraba" e remove a parte "/?update_dyndns=".

Vai sobrar o hostname, "goosfraba".

if not nodename in NODE_IP:

NODE_IP[nodename] = [ None, None ]

Aqui olha se o dicionário NODE_IP tem a chave que é o nodename.

Eu comentei acima hostname, mas no código chamei de nodename.

Tenha em mente que eram a mesma coisa.

E se a chave não existe, eu crio com uma lista vazia.

if re.search("([0-9].*)\.([0-9].*)\.([0-9].*)\.([0-9].*)", ip):

NODE_IP[nodename][0] = ip

debug(f"{nodename} (ipv4): {ip}")

else:

NODE_IP[nodename][1] = ip

debug(f"{nodename} (ipv6): {ip}")

Finalmente eu comparo o ip se bate com o padrão ([0-9].*)\.([0-9].*)\.([0-9].*)\.([0-9].*) que

é basicamente qualquer número de 0 à 9 seguido de ponto.

Então se eu recebesse um IP inválido, como 999.9999999.999999999999.99999999, validaria.

Mas pro script XGH, foi suficiente.

Daí eu sei se é um IPv4.

Se não for, é IPv6.

Como vou lendo o arquivo LOG de cima pra baixo,

esses valores de hostname e ip é atualizado várias vezes.

Com os mesmos valores.

E como o servidor web atualiza também de cima pra baixo, a última linha deve ser a mais atual.

Não muito eficiente, mas dá certo.

XGH raiz.

O apply_translate( ) eu não vou comentar.

Já expliquei acima o que ele faz, que é traduzir hostname pra entrada no dns.

Não adiciona muita coisa.

Então vamos pro próximo.

O próximo é um XGH raiz.

Função grande.

É a check_for_update( ).

Vamos por partes.

def check_for_update(DIC):

debug("check_for_update()")

isupdated = False

buf = ""

debug("check_for_update(): current DNS entries")

with open(DNSCONF) as fh:

for line in fh.readlines():

if line.startswith(";") or line.startswith("#"):

buf += line

continue

line = line.rstrip()

param = line.split()

if len(param) != 3:

buf += f"{line}\n"

continue

Aqui é lido o arquivo DNSCONF, que é onde está o mapa "ip tipo nome" como "1.2.3.4 A helio".

Essa primeira parte descarta as linhas que começam ou com ";" ou com "#".

Na verdade copia a linha como está em buf.

A parte de baixo prepara a linha pra ser lida se tiver o padrão de ter ao menos 3 parâmetros quando separada por espaços.

Se não for, copie pro buffer e vá pra próxima linha.

subname, subtype, subip = param

print(f"DNS current entry: {subname}, Type: {subtype}, IP: {subip}")

if not subname in DIC:

debug(f"check_for_update(): {subname} is not into the DIC")

buf += f"{line}\n"

continue

Aqui já pega os 3 parâmetros que serão subname, subtype, subip.

O subname é o hostname.

Ou nodename.

Consistência não é meu forte.

Ou não era.

E se esse hostname não estiver no dicionário, salva a linha como ela era no buffer e vai pra próxima linha.

ipv4, ipv6 = DIC[subname]

print(f"Found {subname} for update")

# ipv4

if subtype == "A":

print("Checking IPv4")

if ipv4 != subip and len(ipv4) > 0:

print(f" * Updating {subname} from {subip} to {ipv4}")

isupdated = True

buf += f"{subname}\t\t\t{subtype}\t{ipv4}\n"

continue

# ipv6

if subtype == "AAAA":

print("Checking IPv6")

if ipv6 != subip and len(ipv6) > 0:

print(f" * Updating {subname} from {subip} to {ipv6}")

isupdated = True

buf += f"{subname}\t\t\t{subtype}\t{ipv6}\n"

continue

buf += f"{line}\n"

Aqui os endereços IPv4 e IPv6 são recuperados do dicionário em ipv4, ipv6 = DIC[subname].

Se o subtipo for "A", eu olho se o endereço IPv4 mudou.

Se for "AAAA", olho o IPv6.

Se alterar, eu altero isupdated pra verdadeiro.

if isupdated:

print(f"Updating file {DNSCONF}")

debug("check_for_update(): buf:", buf)

with open(DNSCONF, 'w') as fh:

fh.write(buf)

return isupdated

E finalmente, se o código foi alterado, escrevo em cima do arquivo antigo o conteúdo novo.

Até aqui tudo bem.

O código está meio rebuscado e com alguns pontos de XGH mas parece funcional.

Vamos então olhar a próxima parte, que é atualizar os mapas caso tenha tido alguma mudança.

Olhando pra update_timestamp( ) vamos ver que esse depende de outras funções, que ficam pra cima no código.

E aqui já entra um pequeno mal estar.

Eu gosto dos conselhos do Uncle Bob sobre clean code.

E prefiro ler um código de cima pra baixo.

Usou uma função ou método?

Coloque abaixo.

Na ordem em que foi chamado.

Mas com python com funções isso não funciona.

Você tem de colocar acima as funções que serão chamadas abaixo.

Então vamos lá.

def update_timestamp(dryrun=False):

debug("update_timestamp()")

buf = ""

today = time.strftime("%Y%m%d", time.localtime())

timestamp = get_dns_map_serial(DNSDATE)

Bem básico.

Pega o dia de hoje no formato "YYYMMDD".

Em seguida olha qual o serial do arquivo com get_dns_map_serial( ).

Ao contrário do que fiz até agora, eu vou parar de analizar essa função e seguir o código que ela chamou.

def get_dns_map_serial(dns_file: str) -> str:

with open(dns_file) as fh:

for line in fh.readlines():

if not re.search(" ; serial", line):

continue

timestamp = line.split()[0]

return timestamp

raise Exception(f"Failed to read serial from dns file: {dns_file}")

Esse trecho de código é claramente mais recente. Usando f-strings e mais type hints pra saber o que seria ali. E variáveis em minúsculas! E bem simples: abre o arquivo passado (um mapa de dns) e busca pela linha com "; serial". Quebra a linha em espaços e retorna o primeiro parâmetro encontrado. Não tem verificação se realmente voltou uma string, mas parece ser isso. E se não achar nada, lança uma exceção e para a execução toda. Um pouco demais, mas pelo menos não retorna algo errado e deixa destruir o mapa de dns.

Vamos então voltar a olhar a função chamadora, update_timestamp( ).

(last_update, last_serial) = get_serial_date_update(timestamp)

Novamente um código mais enxuto.

Ao invés de manter no corpo da função, chamar outra função auto-explicativa.

Então vamos olhar a get_serial_date_update( ).

def get_serial_date_update(timestamp: str) -> list:

if len(timestamp) != 10 :

raise Exception(f"Wrong timestamp size (not 10): {timestamp}")

dateformat = timestamp[:8]

serial = timestamp[8:]

return (serial)

Aqui ele verifica se o serial tem 10 caractéres, ou 10 dígitos com if len(timestamp) != 10.

Ou gera uma exceção e encerra a execução.

Pega os primeiro 8 caractéres e coloca em dateformat.

Em seguida pega os caractéres restantes e coloca em serial.

E retorna o serial.

Perceberam os problemas?

Já começa que a função chama-se get_serial_date_update( ).

Qual o update?

E deveria retornar uma lista.

Até volta, mas com um valor só, o serial.

A função que chamava esperava o quê?

Esperava isso aqui: (last_update, last_serial) = get_serial_date_update(timestamp).

Então recebe last_update mas não last_serial.

Achamos um 🪲.

Vamos então continuar em update_timestamp( ).

print("Timestamp:", timestamp)

print("Last update:", last_update)

print("Last serial:", last_serial)

original_timestamp = ""

if int(today) > int(last_update):

timestamp = f"{today}00"

else:

serial = int(last_serial) + 1

if serial < 100:

timestamp = "%s%02d" % (today, serial)

else:

timestamp = "%08d00" % (int(today) + 1)

print("New timestamp:", timestamp)

Aqui a data today é transformada em int (integer, inteiro) e comparada com last_update, que também é transformado em int.

Se for maior, mais atual, então inicializa com "00".

Se não for mais atual, então incrementa o número serial em 1.

E olha se for maior que 100, incializa o dia seguinte e começa com 00 de novo.

E finalmente:

if dryrun is False:

update_serial_in_file(original_timestamp, timestamp, DNSDATE)

Se não está rodando em dry-run, rodar esse update_serial_in_file( ).

Pelo nome é possível deduzer que seja trocar o serial antigo do arquivo pelo novo.

Mas vamos olhar o código.

def update_serial_in_file(old_serial: str, new_serial: str, filename: str) -> None:

with open(filename) as fh:

buf = fh.read()

buf = re.sub(old_serial, new_serial, buf)

with open(filename, 'w') as fw:

fw.write(buf)

E sim, é basicamente isso mesmo. Ler o arquivo todo, trocar a string antiga pela nova, e salvar.

E com isso chegamos na parte final do script:

bind_restart(dryrun=doDryRun)

É bem descritivo e faz exatamente o que diz: reinicia o serviço de dns via systemd.

def bind_restart(dryrun=False):

#cmd = "systemctl restart named.service"

## reload is enough

cmd = "systemctl reload named.service"

if dryrun is False:

subprocess.call(cmd.split())

else:

print("-= dry-run mode =-")

print(f"Here command would be called: {cmd}")

Se teve paciência de ler até aqui, espero que tenha gostado e aprendido que esse código estava bem ruim. E o que seria um código bom? Com certeza um que seja legível de cima pra baixo. Até certo ponto porque python não é tão flexível assim. Sem delongas, vou mostrar o código novo. Depois vou explicando.

#! /usr/bin/python3 -u

# -*- encoding: utf-8 -*-

"""

DNS updater. It checks if hostname and IP are updated

on maps. If not, update accordingly and reload bind.

"""

# grep "\/\?node=" /var/log/apache2/dyndns-access.log | sed "s/ HTTP.*//" | awk '{print $1, $NF}'

import re

import time

import os

import subprocess

import sys

import argparse

import logging

logger = logging.getLogger(__file__)

consoleOutputHandler = logging.StreamHandler()

logger.addHandler(consoleOutputHandler)

logger.setLevel(logging.INFO)

TRANSLATE = {

"goosfraba" : "helio",

"raspberrypi-masoso" : "rpi0",

"raspberrypi1" : "rpi1",

"raspberrypi2" : "rpi2",

"raspberrypi3" : "rpi3"

}

class DnsIPUpdate:

'''

A class that reads httpd logs for patterns in order to find a host IP,

update dns file accordingly if needed and restart dns service if updated.

'''

def __init__(self, args: argparse.Namespace):

self._logfile: str = args.logfile

self._bindfiles: list = args.bindfiles.split(",")

self._IPv4: dict = {}

self._IPv6: dict = {}

self._dryrun: bool = args.dryrun

self._dyndnsfile: str = args.dyndnsfile

self._fakesystemd: bool = args.fakesystemd

# for the serial on the dns files

self._year: str = time.strftime("%Y", time.localtime())

self._month: str = time.strftime("%m", time.localtime())

self._day: str = time.strftime("%d", time.localtime())

def update(self):

'run the update'

matched_lines: list = self.getEntriesFromLogs()

self._populateIPsData(matched_lines)

logger.debug(f'IPv4s: {self._IPv4}')

logger.debug(f'IPv6s: {self._IPv6}')

self._applyTranslation()

logger.debug(f'IPv4s: {self._IPv4}')

logger.debug(f'IPv6s: {self._IPv6}')

if not self._dryrun:

resp: bool = self._updateDNSFiles()

if resp is True:

self._restartService()

def getEntriesFromLogs(self) -> list:

'return the matching lines from logging file'

matches: list = []

with open(self._logfile) as fd:

for line in fd.readlines():

if not re.search(r"\/\?update_dyndns=", line):

continue

line = line.rstrip()

logger.debug(f"found line in log: {line}")

matches.append(line)

return matches

def _populateIPsData(self, matches):

'fill the IPv4 and IPv6 structures with IPs and hostnames'

for line in matches:

ip_addr, _, _, timestamp, timezone, method, uri, http_version, status_code, size, _, user_agent = line.split()

timestamp = timestamp[1:]

timezone = timezone[:-1]

method = method[1:]

http_version = http_version[:-1]

user_agent = user_agent[1:-1]

logger.debug(f"ip={ip_addr} timestamp={timestamp} timezone={timezone} method={method} uri={uri} proto={http_version} status_code={status_code} size={size} agent={user_agent}")

hostname = self._getHostName(uri)

if self._isIPv4(ip_addr):

self._IPv4[hostname] = ip_addr

else:

self._IPv6[hostname] = ip_addr

def _isIPv4(self, ip: str) -> bool:

'quickly finds out whether IPv4 or not - then IPv6'

if re.search("^((25[0-5]|2[0-4][0-9]|[01]?[0-9][0-9]?)\\.){3}(25[0-5]|2[0-4][0-9]|[01]?[0-9][0-9]?)$", ip):

return True

return False

def _getHostName(self, uri: str) -> str:

'filter uri to return only the hostname'

hostname = re.sub(r",.*", "", uri)

hostname = re.sub(r".*update_dyndns=", "", hostname)

return hostname

def _applyTranslation(self) -> None:

'translate hostname according to table'

for old_name, new_name in TRANSLATE.items():

if old_name in self._IPv4:

logger.debug(f"Translating IPv4: from={old_name} to={new_name}")

self._IPv4[new_name] = self._IPv4[old_name]

del self._IPv4[old_name]

if old_name in self._IPv6:

logger.debug(f"Translating IPv6: from={old_name} to={new_name}")

self._IPv6[new_name] = self._IPv6[old_name]

del self._IPv6[old_name]

def _updateDNSFiles(self) -> bool:

'check and update DNS files if needed'

isUpdated = self._updateDynDNS()

if isUpdated is True:

self._updateSerialOnDNS()

return isUpdated

def _updateDynDNS(self) -> bool:

'check each entry into dyndns file and returns true if updated'

status = False # by default we don't update

output = []

with open(self._dyndnsfile) as fd:

buffer = fd.readlines()

for line in buffer:

line = line.rstrip() # remove new line

try:

hostname, _, _, dns_type, ip_addr = line.split("\t")

except ValueError:

output.append(f"{line}\n")

continue

match dns_type:

case "A":

# IPv4

if hostname in self._IPv4:

if self._IPv4[hostname] != ip_addr:

logger.info(f"updating IPv4 for {hostname}: old={ip_addr} new={self._IPv4[hostname]}")

line = f"{hostname}\t\t\tA\t{self._IPv4[hostname]}"

status = True

case "AAAA":

# IPv6

if hostname in self._IPv6:

if self._IPv6[hostname] != ip_addr:

logger.info(f"updating IPv6 for {hostname}: old={ip_addr} new={self._IPv6[hostname]}")

line = f"{hostname}\t\t\tAAAA\t{self._IPv6[hostname]}"

status = True

case _:

pass

output.append(f"{line}\n")

if status is True:

with open(self._dyndnsfile, 'w') as fw:

fw.write("".join(output))

return status

def _updateSerialOnDNS(self) -> None:

for filename in self._bindfiles:

buffer: list = []

logger.debug(f"updating serial on file: {filename}")

with open(filename) as fd:

for line in fd.readlines():

if not re.search("; serial", line):

buffer.append(line)

continue

line = line.rstrip()

logger.debug(f"line with serial number: {line}")

serial = self._sanitizeSerial(line)

logger.debug(f"serial={serial}")

new_serial = self._increaseSerial(serial)

logger.debug(f"new_serial={new_serial}")

line = f"\t\t\t\t{new_serial} ; serial\n"

logger.info(f"updating: filename={filename} old_serial={serial} new_serial={new_serial}")

buffer.append(line)

with open(filename, "w") as fw:

fw.write("".join(buffer))

def _sanitizeSerial(self, serial_nr: str) -> str:

'to remove the \t and spaces'

serial, _ = serial_nr.split(";")

serial = re.sub(r"\t", "", serial)

serial = re.sub(" ", "", serial)

return serial

def _increaseSerial(self, serial_nr: str):

'to identify and increase serial'

year = serial_nr[:4]

month = serial_nr[4:6]

day = serial_nr[6:8]

counter = serial_nr[8:]

today = f"{self._year}{self._month}{self._day}"

serial_date = f"{year}{month}{day}"

if today == serial_date:

new_counter = self._increaseString(counter)

return f"{today}{new_counter}"

else:

return f"{today}00"

def _increaseString(self, str_number: str) -> str:

'convert string to int, increase by one and return as string'

int_number: int = int(str_number)

int_number += 1

return f"{int_number}"

def _restartService(self) -> None:

'restart systemd service'

cmd = ["systemctl", "reload", "named.service"]

logger.info("restarting named.service")

if self._fakesystemd is True:

print(f"here service would be restarted: {cmd}")

else:

subprocess.call(cmd)

def getTimestamp():

return time.strftime("%Y%m%dT%H:%M:%S", time.localtime())

def main():

logger.info(f"starting: {getTimestamp()}")

parser = argparse.ArgumentParser(description='script to update DNS entries for dynamic clients found on httpd logs')

parser.add_argument("--logfile", required=True, help="the httpd log to be checked")

parser.add_argument("--loglevel", default="info", help="logging level for this script")

parser.add_argument("--bindfiles", required=True, help="files separated by \",\" to be updated to update serial")

parser.add_argument("--dyndnsfile", required=True, help="the dyndns map to update the IPs")

parser.add_argument("--dryrun", default=False, type=bool, help='run as dry-run or not (default=false)')

parser.add_argument("--fakesystemd", default=False, type=bool, help='run just a printout instead of systemd')

args = parser.parse_args()

if args.loglevel != "info":

logger.setLevel(args.loglevel.upper())

logger.debug(f"args: {args}")

dns = DnsIPUpdate(args)

dns.update()

logger.info(f"finished: {getTimestamp()}")

if __name__ == '__main__':

main()

A parte de baixo continua mais ou menos igual: chama uma função main( ) que faz tudo.

Mas agora a função main( ) usa argparse pra pegar os argumentos.

Então as constantes com os nomes dos arquivos sumiram e viraram agora argumentos.

Isso facilita escrever testes (o que não fiz ainda).

O que o código faz?

Faz isso aqui:

dns = DnsIPUpdate(args)

dns.update()

Cria um objeto DnsIPUpdate( ) e chama o método update( ).

Não mais funções mas métodos.

Parece mais simples de entender.

Espero.

Vamos então agora olhar a classe. Começando com sua inicialização.

def __init__(self, args: argparse.Namespace):

self._logfile: str = args.logfile

self._bindfiles: list = args.bindfiles.split(",")

self._IPv4: dict = {}

self._IPv6: dict = {}

self._dryrun: bool = args.dryrun

self._dyndnsfile: str = args.dyndnsfile

self._fakesystemd: bool = args.fakesystemd

# for the serial on the dns files

self._year: str = time.strftime("%Y", time.localtime())

self._month: str = time.strftime("%m", time.localtime())

self._day: str = time.strftime("%d", time.localtime())

As variáveis (atributos da classe) vêm do argparse. Todas com o "_" no início pra indicar que são internas. Não que isso importe muito uma vez que não é uma classe feita pra ser usada como biblioteca. E agora IPv4 e IPv6 são estruturas separadas. Do tipo dicionário. E pegamos ano, mês e dia separados.

Vamos então olhar o método chamado, o update( ):

def update(self):

'run the update'

matched_lines: list = self.getEntriesFromLogs()

self._populateIPsData(matched_lines)

logger.debug(f'IPv4s: {self._IPv4}')

logger.debug(f'IPv6s: {self._IPv6}')

self._applyTranslation()

logger.debug(f'IPv4s: {self._IPv4}')

logger.debug(f'IPv6s: {self._IPv6}')

if not self._dryrun:

resp: bool = self._updateDNSFiles()

if resp is True:

self._restartService()

Primeiramente que o método update( ) aparece logo abaixo da inicialização da classe.

Então você lê o código de cima pra baixo, o que é muito desejado.

E o código chama outro método em matched_lines: list = self.getEntriesFromLogs( ), que vai retornar uma lista.

Vamost então olhar o que faz getEntriesFromLogs( ).

def getEntriesFromLogs(self) -> list:

'return the matching lines from logging file'

matches: list = []

with open(self._logfile) as fd:

for line in fd.readlines():

if not re.search(r"\/\?update_dyndns=", line):

continue

line = line.rstrip()

logger.debug(f"found line in log: {line}")

matches.append(line)

return matches

Ele então abre o arquivo _logfile e guarda as linhas com o padrão "/?update_dyndns=".

E em formate de lista.

Depois retorna esses valores.

Não melhorou muito em termos de ler o arquivo todo e fazer o parsing de tudo.

Ficou só mais legível.

Voltando ao update( ) temos logo em seguida: self._populateIPsData(matched_lines).

Então vamos olhar o código de _populateIPsData( ).

def _populateIPsData(self, matches):

'fill the IPv4 and IPv6 structures with IPs and hostnames'

for line in matches:

ip_addr, _, _, timestamp, timezone, method, uri, http_version, status_code, size, _, user_agent = line.split()

timestamp = timestamp[1:]

timezone = timezone[:-1]

method = method[1:]

http_version = http_version[:-1]

user_agent = user_agent[1:-1]